- 博客/

Istio in Action 学习笔记

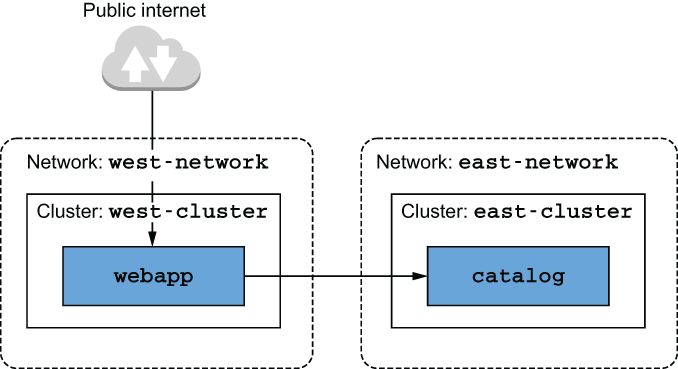

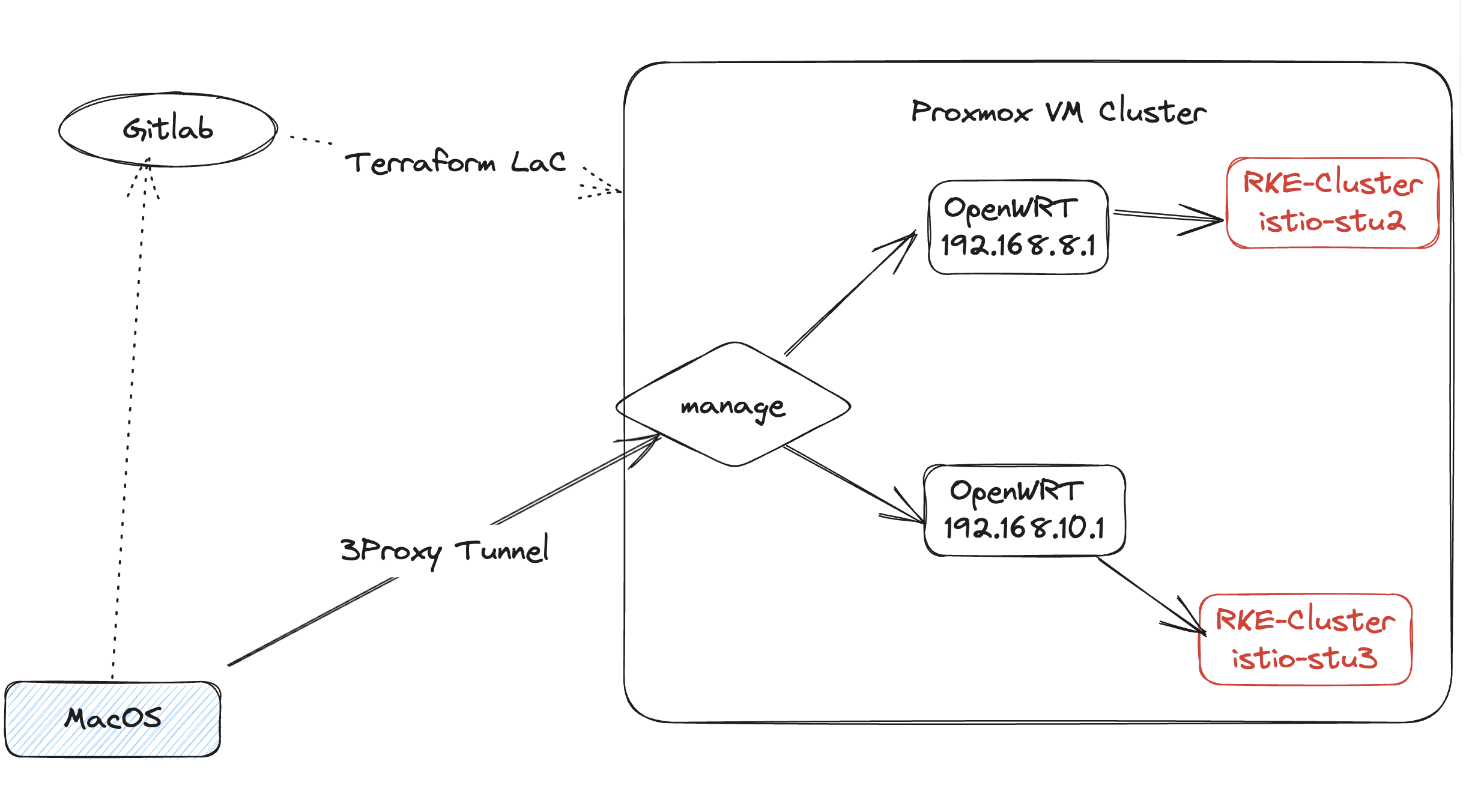

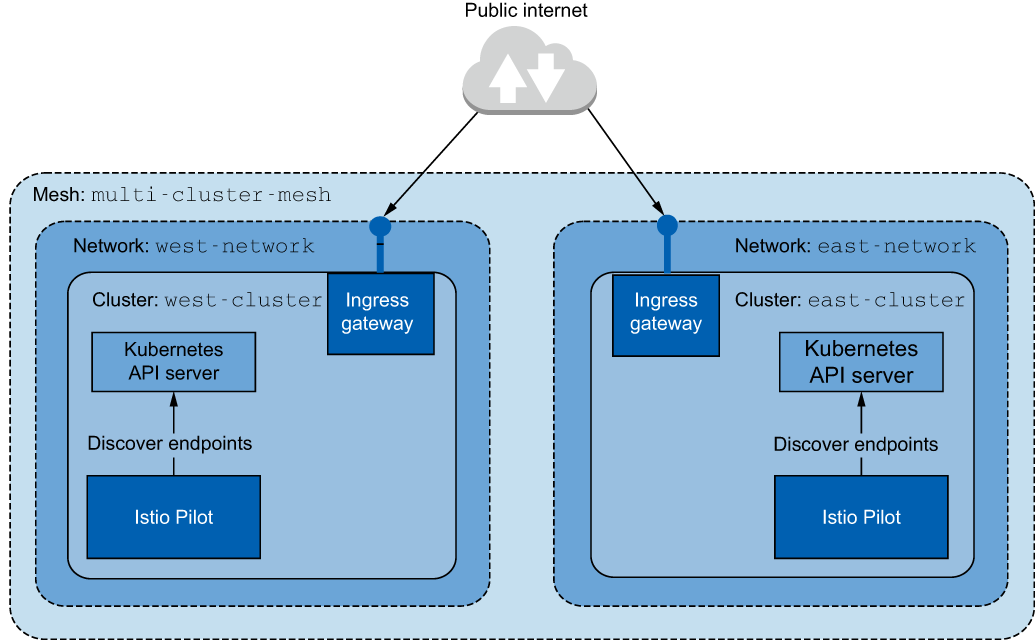

Table of Contents

- Istio 解决的问题

- 技术介绍

- 安装使用

- Envoy proxy

- Envoy Ingress

- 流量控制

- 恢复能力:解决应用网络挑战

- 可观察性

- 可视化

- 关于保障微服务安全

- 数据平面故障排除

- 控制平面的性能调整

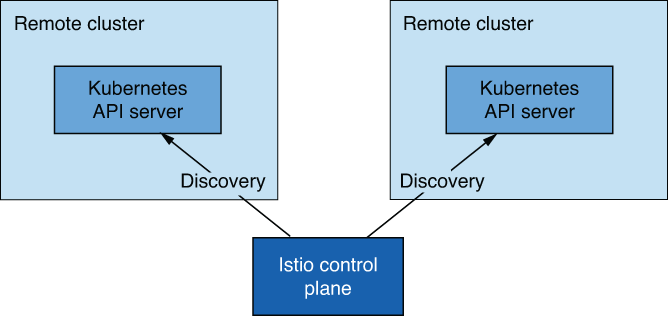

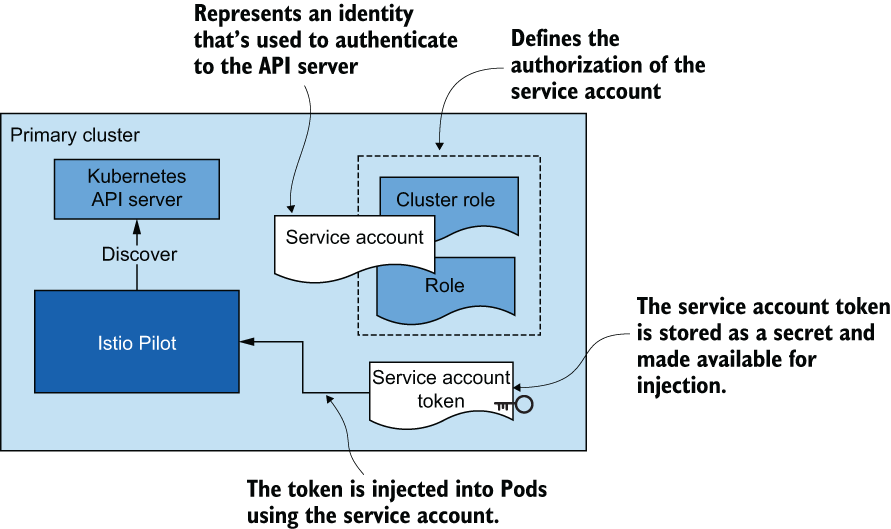

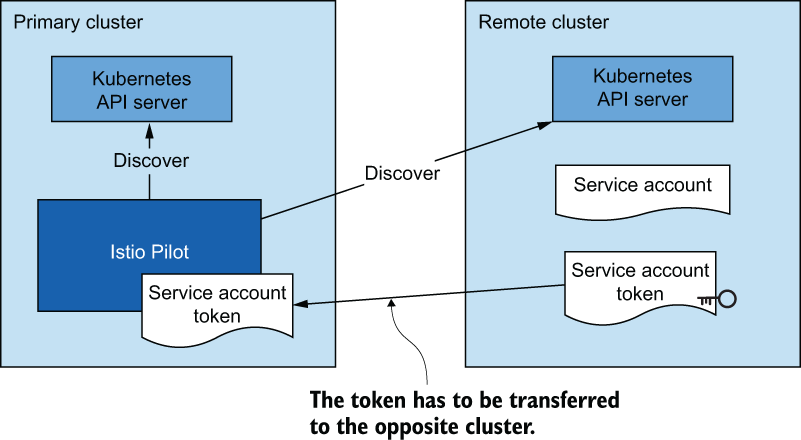

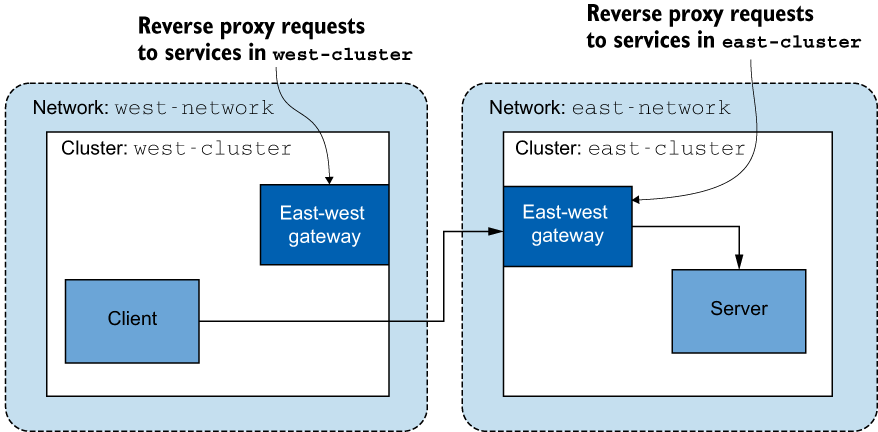

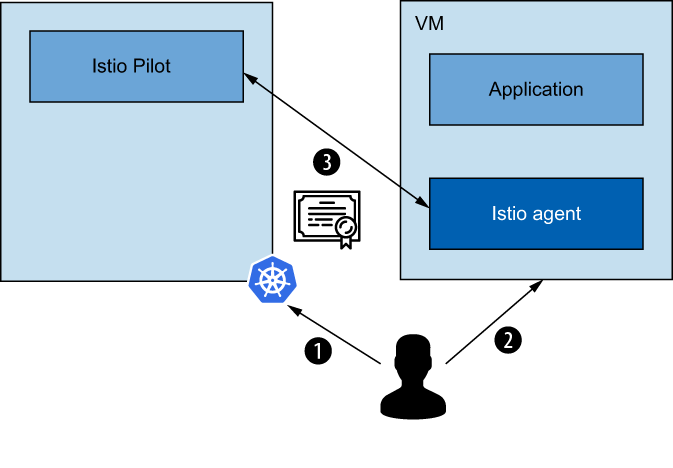

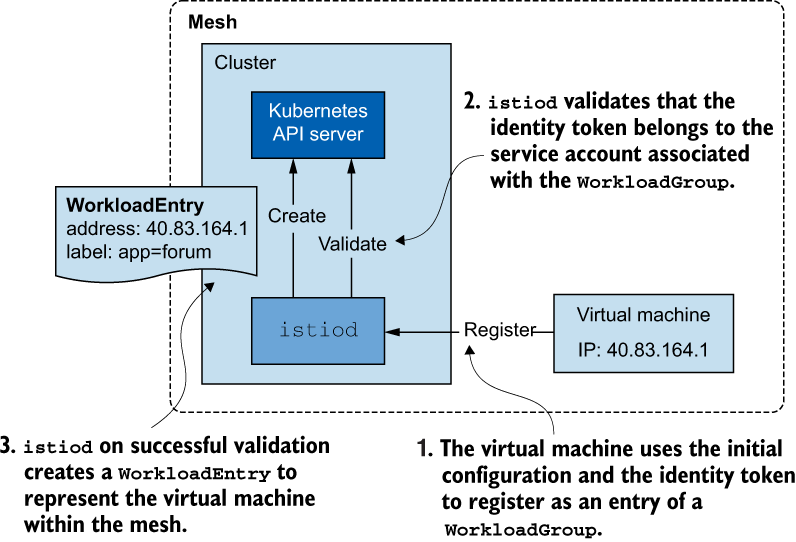

- 网格融合

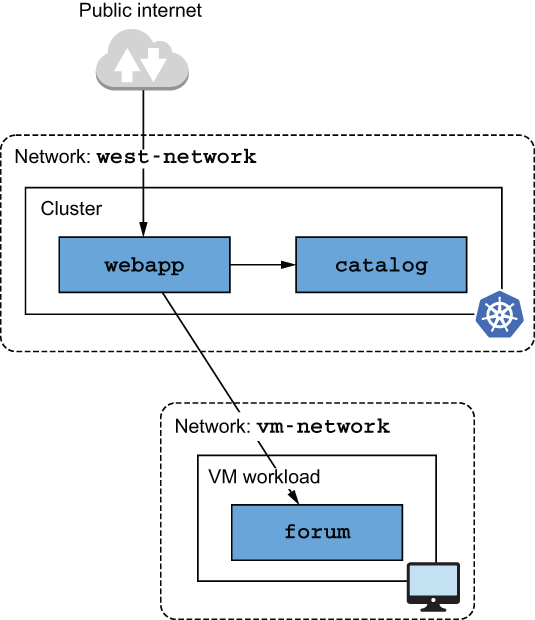

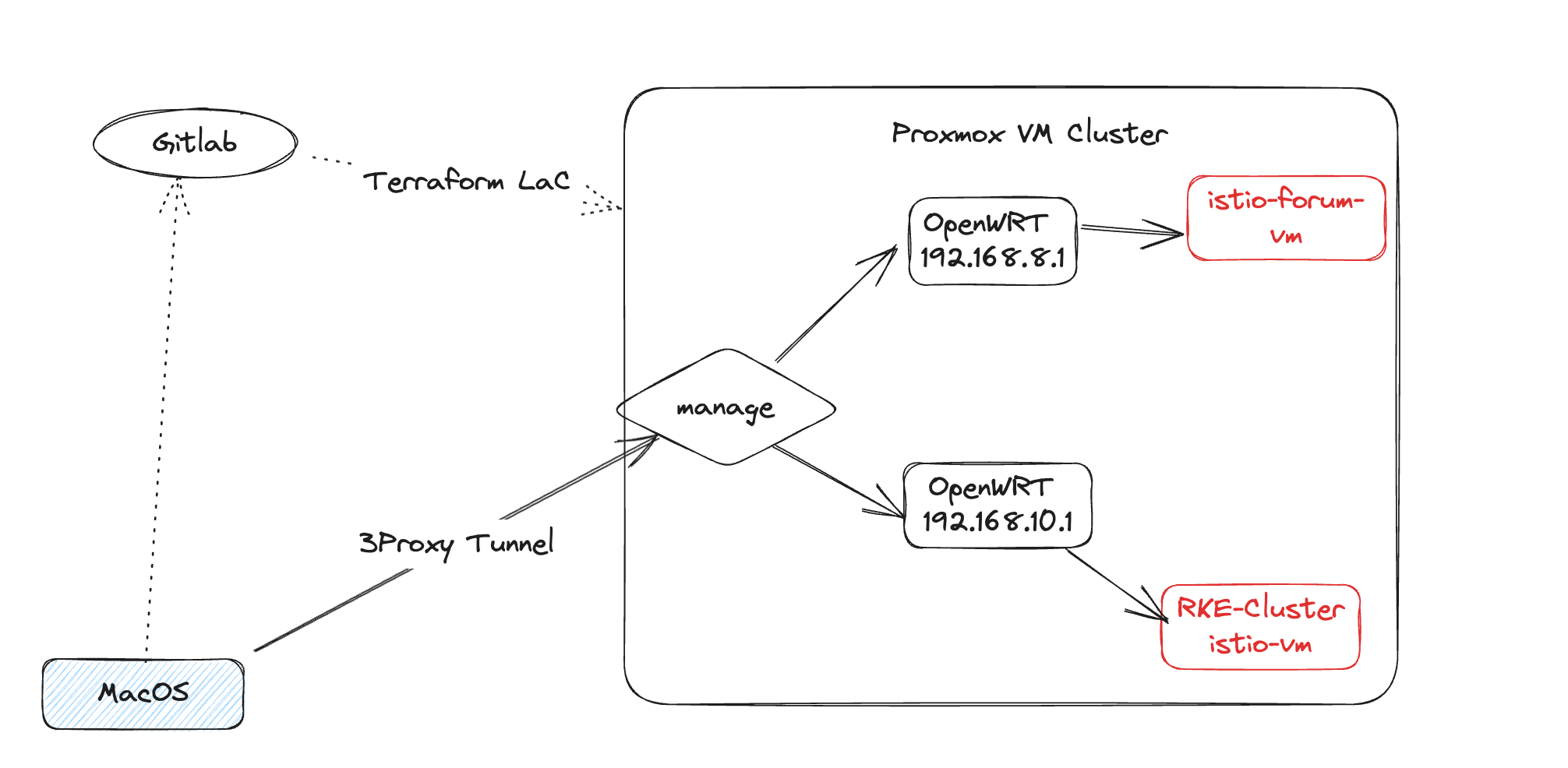

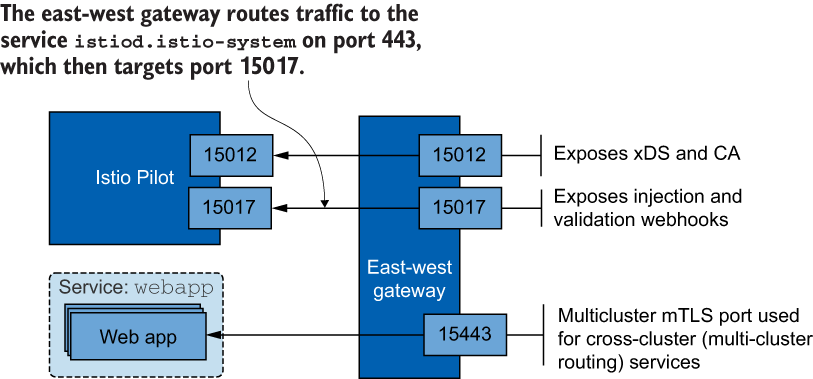

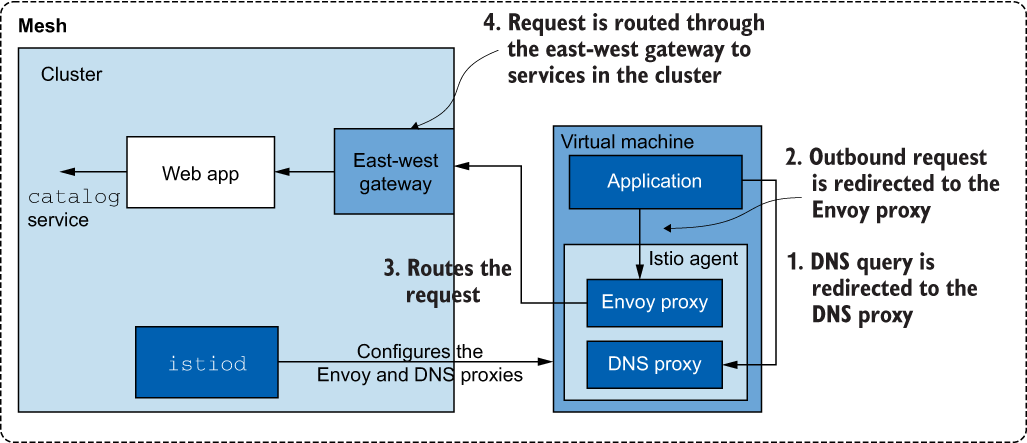

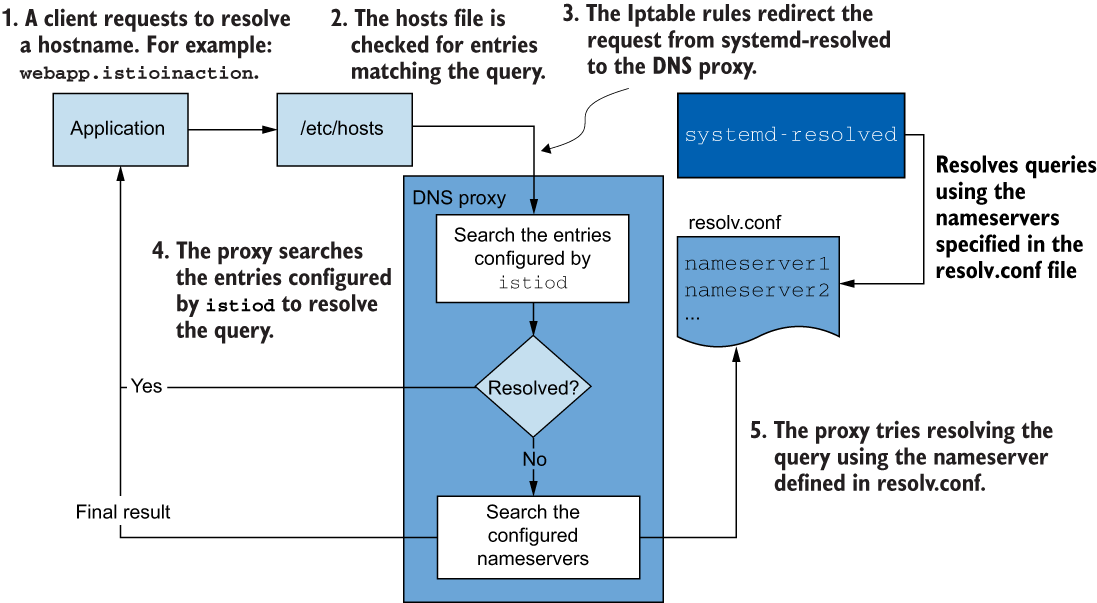

- 虚拟机整合并至网格

- 在请求路径上扩展 Istio

Istio 解决的问题#

基本的应用程序网络问题并非特定于任何特定的应用程序、语言或框架。重试、超时、客户端负载平衡、熔断等也不是区分应用程序功能。它们是作为服务的一部分的关键问题,但是将大量时间和资源投入到您打算使用的每种语言的特定语言实现中(包括上一节中的其他缺点)是浪费时间。我们真正想要的是一种与技术无关的方式来实现这些问题,并使应用程序不必自己这样做。

技术介绍#

Envoy:(http://envoyproxy.io) 是一种服务代理,在开源社区中作为多功能、高性能和功能强大的应用层代理出现。Envoy 是在 Lyft 开发的,是该公司 SOA 基础架构的一部分,能够实现网络问题,如重试、超时、熔断、客户端负载平衡、服务发现、安全性和指标收集,而无需任何明确的语言或框架依赖关系。

- Envoy 还捕获了许多应用程序网络指标,例如每秒请求数、故障数、熔断事件等。

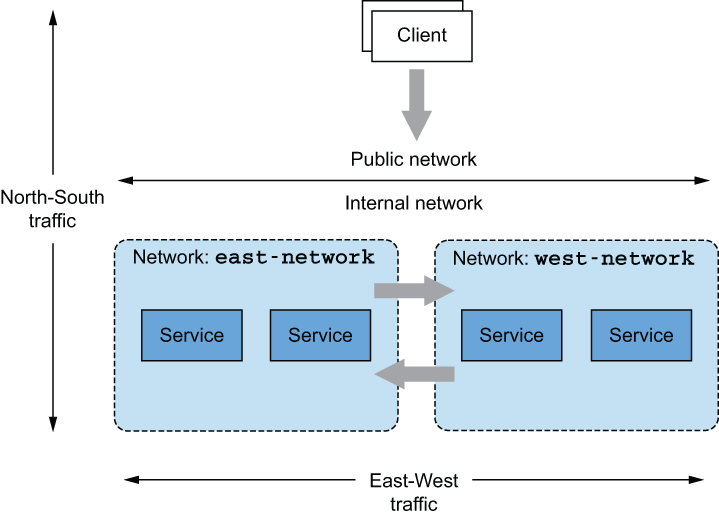

服务网格: 负责通过实现重试、超时和熔断器等功能,使服务通信能够灵活应对故障。

Istio 的控制平面 (

istiod) 用于配置 Istio 代理,用于处理路由、安全性、遥测收集和弹性。请求指标会定期发送回各种收集服务。分布式跟踪跨度(如 Jaeger 或 Zipkin)被发送回跟踪存储,稍后可用于跟踪请求通过系统的路径和延迟。

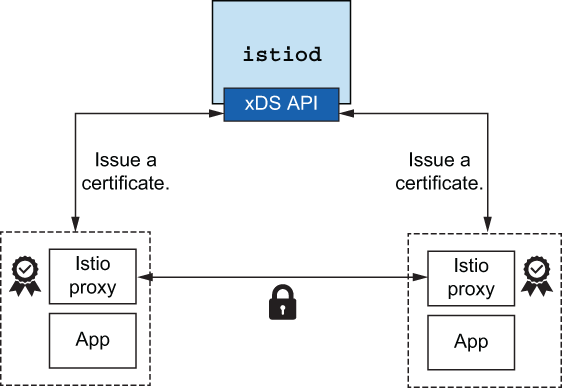

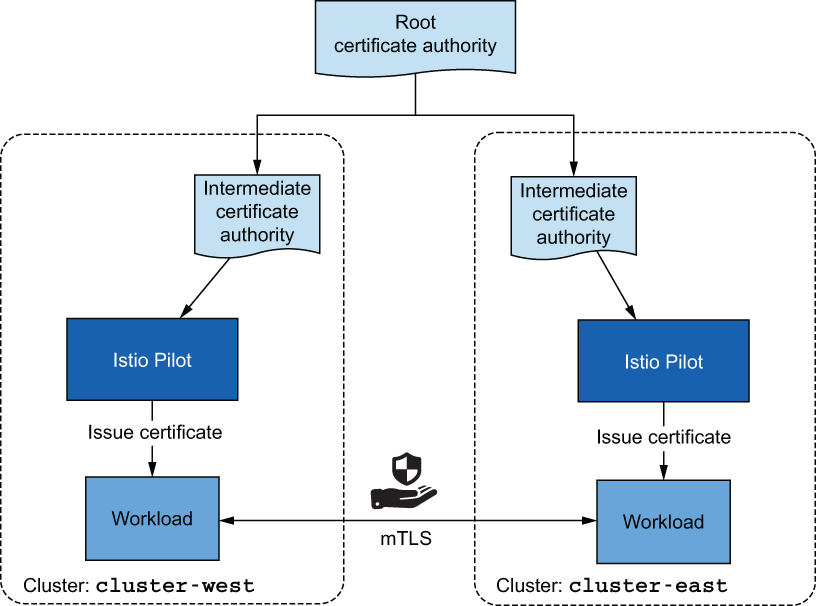

Istio 可以管理密钥和证书的颁发、安装和轮换,以便服务开箱即用地获得双向 TLS。

Istio 为两大类可观察性创建了遥测。第一类是顶线指标,如每秒请求数、故障数和尾部延迟百分位数。

其次,Istio 可以为 OpenTracing.io 这样的分布式跟踪提供便利。Istio 可以将跨度发送到分布式跟踪后端,而无需应用程序操心。

服务网格的缺点是什么?#

- 使用服务网格将另一个中间件(特别是代理)放入请求路径中。这个代理可以提供很多价值;但对于那些不熟悉代理的人来说,它最终可能成为一个黑匣子,使调试应用程序的行为变得更加困难。

- 使用服务网格的另一个缺点是租赁。网格与网格中运行的服务一样有价值。也就是说,网格中的服务越多,网格对于操作这些服务就越有价值。但是,如果没有适当的策略、自动化和深思熟虑进入物理网格部署的租户和隔离模型,您最终可能会遇到错误配置网格会影响许多服务的情况。

- 最后,服务网格成为服务和应用程序体系结构中至关重要的部分,因为它位于请求路径上。服务网格可以公开许多机会来提高安全性、可观测性和路由控制状态。

Istio会使用Kubernetes的服务注册中心来发现服务。

Istio 定义了以下默认提供程序:

prometheus、stackdriver和envoy。您可以使用网格配置中的ExtensionProviderAPI 定义自定义提供程序 (http://mng.bz/REKP)。性能优化

PILOT_FILTER_GATEWAY_CLUSTER_CONFIG

安装使用#

使用 istioctl 部署#

curl -L https://istio.io/downloadIstio | ISTIO_VERSION=1.17.6 sh -

# 检查当前集群安装是否存在问题

istioctl x precheck

# 安装 DEMO 版本

istioctl install --set profile=demo -y

# 查看 POD 是否就绪

kubectl get pod -n istio-system

# 验证安装

istioctl verify-install

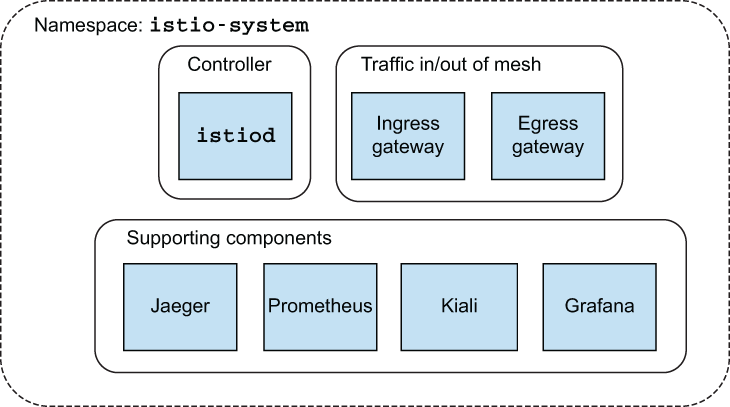

安装控制平面支持组件。

这些组件不是严格必需的,但应该为任何实际部署 Istio 安装。

kubectl apply -f ./samples/addons- 可视化由代理生成并由 Prometheus 收集的指标

- 分布式跟踪系统,可视化通过网格的请求流

- 网格的 Web 控制台

- 收集生成的指标并将其存储为时间序列数据

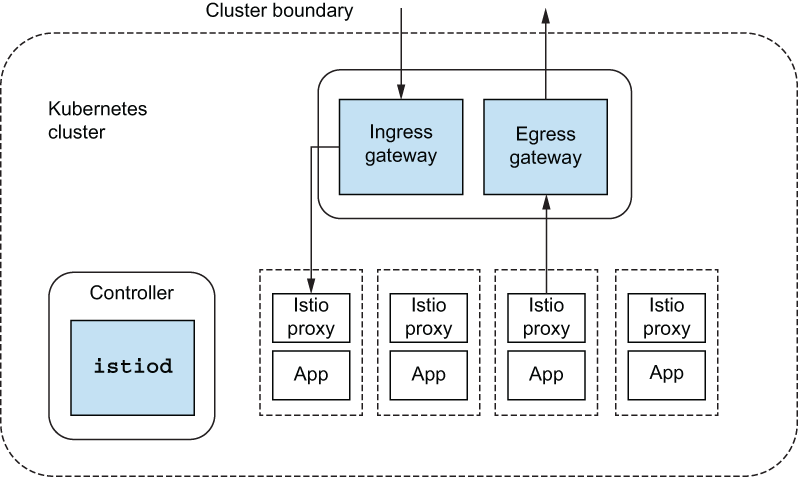

Istio 控制平面#

- 控制平面为服务网格的用户提供了一种控制、观察、管理和配置网格的方法。对于 Istio,控制平面提供了以下功能:

- 供操作员指定所需路由/弹性行为的 API

- 数据平面使用其配置的 API

- 数据平面的服务发现抽象

- 用于指定使用策略的 API

- 证书颁发和轮换

- 工作负载标识分配

- 统一遥测收集

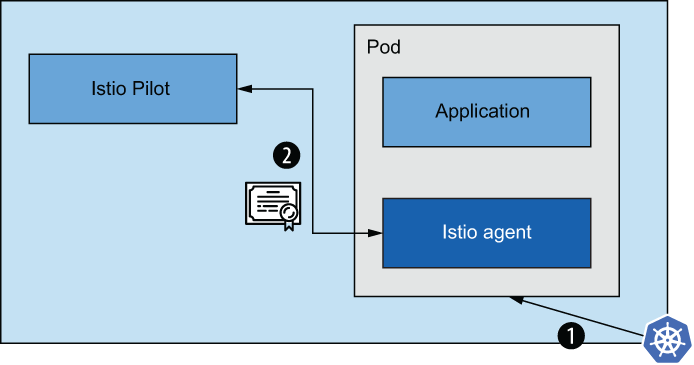

- 服务代理挎斗注入

- 网络边界的规范以及如何访问它们

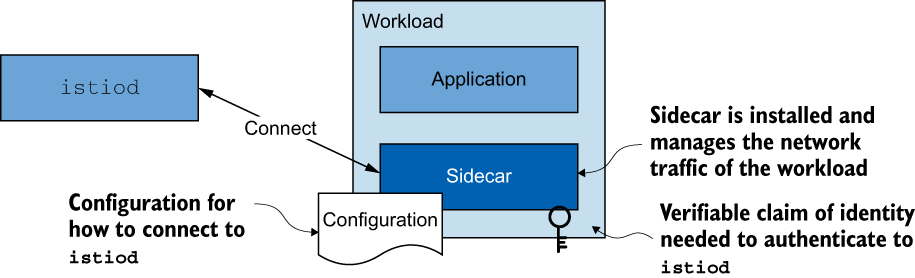

这些职责中的大部分是在称为 的单个控制平面组件中实现的 istiod 。

istiod#

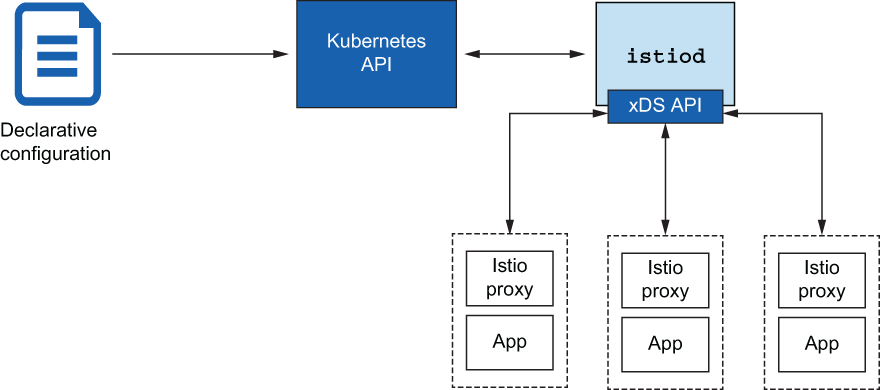

Istio 的控制平面职责在

istiod组件中实现。istiod有时也称为 Istio Pilot,负责接收用户/操作员指定的更高级别的 Istio 配置,并将其转化为每个数据平面服务代理的特定代理配置

istiod获取这些配置并对其进行解释,然后将其作为特定于服务的配置公开。Istio 将 Envoy 用作其服务代理,因此这些配置会被转换为 Envoy 配置istiod公开的数据平面 API 实现了 Envoy 的发现 API- 这些发现 API(如用于服务发现(监听器发现服务 [LDS])、端点(端点发现服务 [EDS])和路由规则(路由发现服务 [RDS])的 API)被称为 xDS API。

- 这些 API 允许数据平面分离其配置方式,并动态调整其行为,而无需停止和重新加载。

- 服务代理与每个应用程序实例并行运行,

所有应用程序流量都通过这些代理传输

-

istio-ingressgateway和istio-egressgateway。以允许流量进入集群,并明确允许哪些流量离开集群。

部署应用#

YAML

$ kubectl create namespace istioinaction $ kubectl config set-context $(kubectl config current-context) \ --namespace=istioinactionapiVersion: v1 kind: Service metadata: labels: app: catalog name: catalog spec: ports: - name: http port: 80 protocol: TCP targetPort: 3000 selector: app: catalog --- apiVersion: apps/v1 kind: Deployment metadata: labels: app: catalog version: v1 name: catalog spec: replicas: 1 selector: matchLabels: app: catalog version: v1 template: metadata: labels: app: catalog version: v1 spec: containers: - env: - name: KUBERNETES_NAMESPACE valueFrom: fieldRef: fieldPath: metadata.namespace image: istioinaction/catalog:latest imagePullPolicy: IfNotPresent name: catalog ports: - containerPort: 3000 name: http protocol: TCP securityContext: privileged: false对该 APP 进行 Istio 注入

istioctl kube-inject -f catalog.yaml|kubectl apply -f -命名空间的自动注入,添加如下 Lable 即可

kubectl label namespace istioinaction istio-injection=enabled验证是否就绪

kubectl run -i -n default --rm --restart=Never dummy \ --image=curlimages/curl --command -- \ sh -c 'curl -s http://catalog.istioinaction/items/1'

istioctl 使用记录#

参考文档: https://istio.io/latest/docs/reference/commands/istioctl/

查看当前配置

istioctl profile dump命令补全

istioctl completion zsh > $(brew --prefix)/share/zsh/site-functions/_istioctl检查路由

istioctl proxy-config routes \ deploy/istio-ingressgateway.istio-system查看 Gateway 路由配置

istioctl proxy-config route deploy/istio-ingressgateway \ -o json --name http.8080 -n istio-system查看 Gateway 所监听的地址

istioctl -n istio-system proxy-config \ listener deploy/istio-ingressgateway检查通过 SDS 交付的证书的状态

istioctl pc secret -n istio-system deploy/istio-ingressgateway如果您没有看到新的证书配置生效,可以重建

istio-ingressgateway解决kubectl delete po -n istio-system -l app=istio-ingressgateway

更新配置

istioctl profile dump > config.yaml istioctl upgrade -f ./config.yaml

更新#

# 更新 istioctl

curl -L https://istio.io/downloadIstio | ISTIO_VERSION=1.19.0 sh -

istioctl version

istioctl x precheck

istioctl upgrade

Envoy proxy#

笔记#

Envoy 由 Lyft 开发,旨在解决构建分布式系统时出现的一些应用网络难题。Envoy 采用

C++编写,旨在提高性能,更重要的是,使其在更高负载梯队中更加稳定和确定。开箱即用的Envoy能理解HTTP 1.1、HTTP 2、gRPC和其他协议,并能添加请求级超时、重试、每次重试超时、熔断和其他弹性功能等行为。

而只能理解连接的基本连接级(L3/L4)代理无法实现这样的功能。Envoy 的设计目的是通过在应用程序进程外运行,

使开发人员免受网络问题的困扰。Istio 的控制平面开箱即实现了 Envoy 服务发现 API。

Envoy 为以下策略提供了开箱即用的

负载均衡算法- Random: 随机

- Round robin: 轮训

- Weighted, least request: 加权,最少请求

- Consistent hashing (sticky): hash 粘性

Envoy 支持基于百分比(即加权)的流量分割/转移。Envoy 还能复制流量,并以 “触发即遗忘 “的模式将该流量阴影化到 Envoy 集群中。

Envoy 可以向 OpenTracing ( http://opentracing.io) 引擎报告跟踪跨度,以便在调用图中直观显示流量、跳数和延迟。

Envoy 还支持 Lua (www.lua.org) 脚本和 WebAssembly (Wasm),从而以较低的侵入式方法扩展 Envoy 功能。

Envoy 主要特性

- 服务发现

- 负载均衡

- 流量和请求路由

- 流量转移和镜像功能

- 网络复原力,重试

- HTTP/2 和 GRPC 支持

- 可观察性与指标收集

- 分布式跟踪的可观察性

- 自动 TLS 生命周期管理

- 流量费率限制

- 支持自定义扩展

Envoy 优势

- 支持 HTTP/2(上游和下游)

- WebAssembly 的可扩展性

- 为维护和扩展而构建的模块化代码库

- 深度协议指标收集

- C++ / 无垃圾收集

- 动态配置,无需热重启

Envoy 由 JSON 或 YAML 格式的配置文件驱动。最初的版本(v1 和 v2)已被弃用,取而代之的是 v3。

Envoy 使用以下 API 进行动态配置: ( 这些 API 统称为

xDS服务。一个配置可以使用其中的一个或某些组合,不必全部使用。)- 监听器发现服务 (LDS)–一种允许 Envoy 查询应在此代理上公开哪些监听器的 API。

- 群集发现服务 (CDS)–一种 API,可让 Envoy 发现该代理应拥有哪些群集以及每个群集各自的配置。

- 端点发现服务 (EDS)–群集配置的一部分,用于指定特定群集使用哪些端点。这是 CDS 的子集。

- 秘密发现服务 (SDS)–用于分发证书的 API。

- 聚合发现服务 (ADS)–对其他 API 的所有更改进行序列化的数据流。您可以使用此单一 API 按顺序获取所有更改。

Envoy 的核心功能#

Envoy 对 L7 流量的概念性理解。

- Listeners : 向外界开放一个端口,应用程序可以连接到该端口。例如,80 端口上的监听器接受流量,并对流量应用任何配置行为

- Routes: 路由规则,用于处理通过侦听器进入的流量。例如,如果收到的请求与

/catalog匹配,则将该流量导向catalog集群。,则将该流量导向catalog集群。 - Clusters: Envoy 可将流量路由至的特定上游服务。例如,

catalog-v1和catalog-v2可以是独立的群集,路由可以指定有关如何将流量导向catalog服务的 v1 或 v2 的规则。

Envoy 功能体验#

拉取镜像

docker pull envoyproxy/envoy:v1.19.0 docker pull curlimages/curl docker pull citizenstig/httpbin启动第一个容器

$docker run -d --name httpbin citizenstig/httpbin $docker run -it --rm --link httpbin curlimages/curl \ curl -X GET http://httpbin:8000/headers { "headers": { "Accept": "*/*", "Host": "httpbin:8000", "User-Agent": "curl/8.3.0" } }创建 Envoy 配置文件

在 15001 端口暴露了一个监听器,并将所有流量路由到我们的

httpbin集群。admin: address: socket_address: { address: 0.0.0.0, port_value: 15000 } static_resources: listeners: - name: httpbin-demo address: socket_address: { address: 0.0.0.0, port_value: 15001 } filter_chains: - filters: - name: envoy.filters.network.http_connection_manager typed_config: "@type": type.googleapis.com/envoy.extensions.filters.network.http_connection_manager.v3.HttpConnectionManager stat_prefix: ingress_http http_filters: - name: envoy.filters.http.router route_config: name: httpbin_local_route virtual_hosts: - name: httpbin_local_service domains: ["*"] routes: - match: { prefix: "/" } route: auto_host_rewrite: true cluster: httpbin_service clusters: - name: httpbin_service connect_timeout: 5s type: LOGICAL_DNS dns_lookup_family: V4_ONLY lb_policy: ROUND_ROBIN load_assignment: cluster_name: httpbin endpoints: - lb_endpoints: - endpoint: address: socket_address: address: httpbin port_value: 8000启动容器

docker run --name proxy --link httpbin envoyproxy/envoy:v1.19.0 \ --config-yaml "$(cat ch3/simple.yaml)"测试一下代理服务器

> docker run -it --rm --link proxy curlimages/curl \ curl -X GET http://proxy:15001/headers { "headers": { "Accept": "*/*", "Host": "httpbin", "User-Agent": "curl/8.3.0", "X-Envoy-Expected-Rq-Timeout-Ms": "15000", "X-Request-Id": "a6f3efa5-1f10-4a1f-a18d-fed6006d70ce" } } # 流量被正确发送到了 httpbin 服务。还新增了一些标头

Envoy 的管理 API#

docker run -it --rm --link proxy curlimages/curl \

curl -X GET http://proxy:15000/stats

docker run -it --rm --link proxy curlimages/curl \

curl -X GET http://proxy:15000/stats | grep retry # 只显示包含 retry 的统计数据

Envoy Ingress#

例如,如果您有 Kafka 或 NATS.io 工作负载,您可能希望公开与这些消息系统的直接 TCP 连接。 Kubernetes Ingress 不允许这样做。

Kubernetes Ingress v1 资源的指定严重不足。没有通用的方法来指定复杂的流量路由规则、流量分割或流量阴影等内容

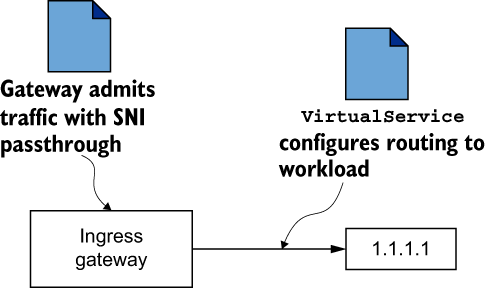

Istio 决定从头开始构建入口模式,并专门将第 4 层(传输)和第 5 层(会话)属性与第 7 层(应用程序)

路由问题分开。- Istio

Gateway处理 L4 和 L5 问题,而VirtualService处理 L7 问题。

- Istio

Istio 的实现和资源出现在 Gateway API 之前,

并在很多方面启发了 Gateway API。API 网关: Istio 的入口网关并没有

开箱即用地执行这些操作。https://docs.solo.io/gloo-edge/latestIstio 的网关实现允许我们

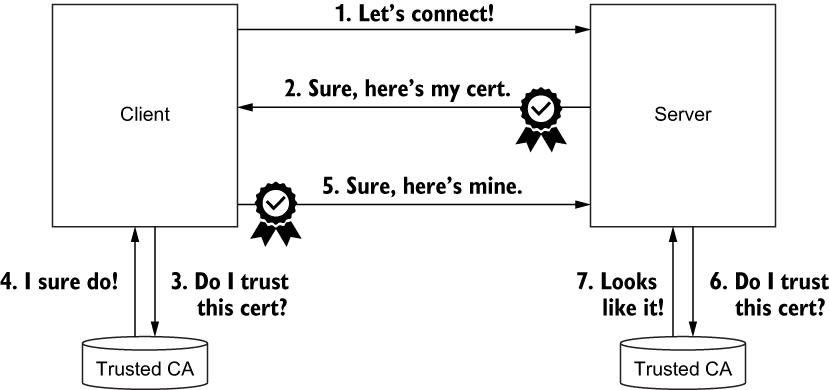

终止传入的 TLS/SSL 流量,将其传递到后端服务,将任何非 TLS 流量重定向到正确的 TLS 端口,并实现相互 TLS。TLS 握手包括一个更复杂的协议,

该协议结合了用于初始通信的公钥/私钥(非对称),然后创建一个会话密钥(对称),用于 TLS 会话进行加密和加密。解密流量。

VirtualService#

具有虚拟服务的网关路由

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: catalog-vs-from-gw

spec:

hosts:

- "catalog.istioinaction.io"

gateways:

- coolstore-gateway

http:

- route:

- destination:

host: catalog

port:

number: 80

网关 TLS#

集成cert-manager 之类的工具可以管理密钥 。

- 创建 webapp-credential 配置密钥

kubectl create -n istio-system secret tls webapp-credential \

--key ch4/certs/3_application/private/webapp.istioinaction.io.key.pem \

--cert ch4/certs/3_application/certs/webapp.istioinaction.io.cert.pem

配置 Gateway 使用密钥

apiVersion: networking.istio.io/v1alpha3 kind: Gateway metadata: name: coolstore-gateway spec: selector: istio: ingressgateway servers: - port: number: 80 name: http protocol: HTTP hosts: - "webapp.istioinaction.io" - port: number: 443 name: https protocol: HTTPS tls: mode: SIMPLE credentialName: webapp-credential hosts: - "webapp.istioinaction.io"验证

# 访问 网关的 443 NodePort 端口 curl -v -H "Host: webapp.istioinaction.io" https://192.168.8.170:32316/api/catalog curl -H "Host: webapp.istioinaction.io" \ https://webapp.istioinaction.io:32316/api/catalog \ --cacert ch4/certs/2_intermediate/certs/ca-chain.cert.pem \ --resolve webapp.istioinaction.io:32316:192.168.8.170 [{"id":1,"color":"amber","department":"Eyewear","name":"Elinor Glasses","price":"282.00"},{"id":2,"color":"cyan","department":"Clothing","name":"Atlas Shirt","price":"127.00"},{"id":3,"color":"teal","department":"Clothing","name":"Small Metal Shoes","price":"232.00"},{"id":4,"color":"red","department":"Watches","name":"Red Dragon Watch","price":"232.00"}]

HTTP 重定向到 HTTPS#

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: coolstore-gateway

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "webapp.istioinaction.io"

tls:

httpsRedirect: true

- port:

number: 443

name: https

protocol: HTTPS

tls:

mode: SIMPLE

credentialName: webapp-credential

hosts:

- "webapp.istioinaction.io"

curl -L -v http://192.168.8.170:31193/api/catalog \

-H "Host: webapp.istioinaction.io"

具有双向 TLS 的 HTTP 流量#

直观地展示了客户端和服务器如何通过双向 TLS (mTLS) 协议验证彼此的证书,即相互验证。证书用于加密流量。

配置

istio-ingressgateway-ca-certs密钥kubectl create -n istio-system secret \ generic webapp-credential-mtls --from-file=tls.key=\ ch4/certs/3_application/private/webapp.istioinaction.io.key.pem \ --from-file=tls.crt=\ ch4/certs/3_application/certs/webapp.istioinaction.io.cert.pem \ --from-file=ca.crt=ch4/certs/2_intermediate/certs/ca-chain.cert.pem更新 Istio

Gateway资源以指向 CA 证书链的位置,并将预期协议配置为双向 TLS- port: number: 443 name: https protocol: HTTPS tls: mode: MUTUAL ❶ credentialName: webapp-credential-mtls ❷测试

curl -H "Host: webapp.istioinaction.io" \ https://webapp.istioinaction.io:32316/api/catalog \ --cacert ch4/certs/2_intermediate/certs/ca-chain.cert.pem \ --resolve webapp.istioinaction.io:32316:192.168.8.170 curl: (56) LibreSSL SSL_read: LibreSSL/3.3.6: error:1404C45C:SSL routines:ST_OK:reason(1116), errno 0 # 此调用被拒绝,因为 SSL 握手未成功。我们仅将 CA 证书链传递给 curl 命令;我们还需要传递客户端的证书和私钥。 ➜ book-source-code git:(master) ✗ curl -H "Host: webapp.istioinaction.io" \ https://webapp.istioinaction.io:32316/api/catalog \ --cacert ch4/certs/2_intermediate/certs/ca-chain.cert.pem \ --resolve webapp.istioinaction.io:32316:192.168.8.170 \ --cert ch4/certs/4_client/certs/webapp.istioinaction.io.cert.pem \ --key ch4/certs/4_client/private/webapp.istioinaction.io.key.pem [{"id":1,"color":"amber","department":"Eyewear","name":"Elinor Glasses","price":"282.00"},{"id":2,"color":"cyan","department":"Clothing","name":"Atlas Shirt","price":"127.00"},{"id":3,"color":"teal","department":"Clothing","name":"Small Metal Shoes","price":"232.00"},{"id":4,"color":"red","department":"Watches","name":"Red Dragon Watch","price":"232.00"}]Istio 网关 SDS

Istio 网关从内置于用于启动

istio-proxy的istio-agent进程中的秘密发现服务 (SDS) 获取证书。 SDS 是一个动态 API,应该自动传播更新。

TLS 为多个虚拟主机提供服务#

servers:

- port:

number: 443 ❶

name: https-webapp

protocol: HTTPS

tls:

mode: SIMPLE

credentialName: webapp-credential

hosts:

- "webapp.istioinaction.io"

- port:

number: 443 ❷

name: https-catalog

protocol: HTTPS

TCP 流量#

当 Istio 将流量视为普通 TCP 时,我们无法获得许多有用的功能,例如重试、请求级熔断、复杂路由等。这只是因为 Istio 无法判断正在使用什么协议(除非使用 Istio 理解的特定协议,例如 MongoDB)。

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: echo-tcp-gateway

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 31400

name: tcp-echo

protocol: TCP

hosts:

- "*"

---

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: tcp-echo-vs-from-gw

spec:

hosts:

- "*"

gateways:

- echo-tcp-gateway ❶

tcp:

- match:

- port: 31400 ❷

route:

- destination:

host: tcp-echo-service ❸

port:

number: 2701

SNI 直通的流量路由#

配置为使用

PASSTHROUGH作为其路由机制的Gateway定义

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: sni-passthrough-gateway

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 31400 ❶

name: tcp-sni

protocol: TLS

hosts:

- "simple-sni-1.istioinaction.io" ❷

tls:

mode: PASSTHROUGH ❸

---

kubectl get svc -n istio-system istio-ingressgateway \

-o jsonpath='{.spec.ports[?(@.name == "tcp")]}'

curl -H "Host: simple-sni-1.istioinaction.io" \

https://simple-sni-1.istioinaction.io:31332/api/catalog \

--cacert ch4/sni/simple-sni-1/2_intermediate/certs/ca-chain.cert.pem \

--resolve simple-sni-1.istioinaction.io:31332:192.168.8.170

{

"name": "simple-tls-service-1",

"uri": "/api/catalog",

"type": "HTTP",

"ip_addresses": [

"10.42.4.12"

],

"start_time": "2023-09-28T11:13:03.866815",

"end_time": "2023-09-28T11:13:03.866956",

"duration": "141.018µs",

"body": "Hello from simple-tls-service-1!!!",

"code": 200

}

---

# 测试请求使用相同证书的第二个服务

curl -H "Host: simple-sni-2.istioinaction.io" \

https://simple-sni-2.istioinaction.io:31332/api/catalog \

--cacert ch4/sni/simple-sni-2/2_intermediate/certs/ca-chain.cert.pem \

--resolve simple-sni-2.istioinaction.io:31332:192.168.8.170

{

"name": "simple-tls-service-2",

"uri": "/api/catalog",

"type": "HTTP",

"ip_addresses": [

"10.42.8.19"

],

"start_time": "2023-09-28T11:15:05.359662",

"end_time": "2023-09-28T11:15:05.359796",

"duration": "134.13µs",

"body": "Hello from simple-tls-service-2!!!",

"code": 200

}

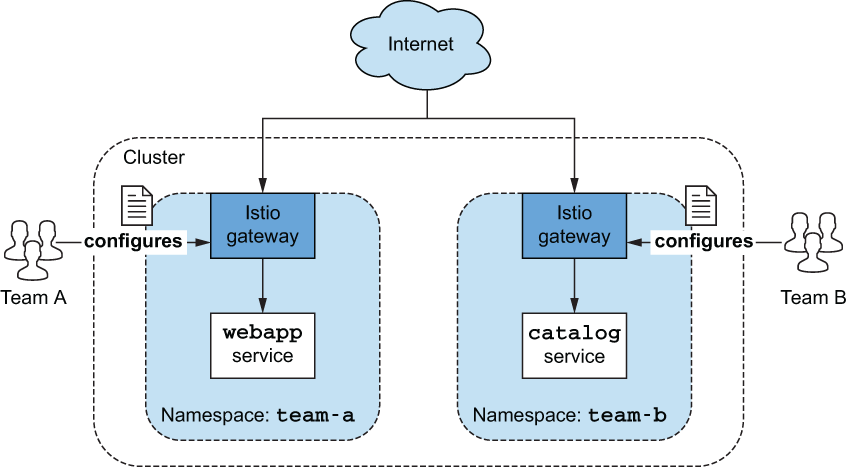

自定义网关#

某些服务可能对性能更敏感,或者出于合规性原因需要更高的可用性或隔离性。有时您希望让各个团队拥有自己的网关和配置,而不影响其他团队。

https://istio.io/latest/docs/setup/install/istioctl/#configure-gateways

安装自定义网关

apiVersion: install.istio.io/v1alpha1

kind: IstioOperator

metadata:

name: my-user-gateway-install

namespace: istioinaction

spec:

profile: empty

values:

gateways:

istio-ingressgateway:

autoscaleEnabled: false

components:

ingressGateways:

- name: istio-ingressgateway

enabled: false

- name: my-user-gateway

namespace: istioinaction

enabled: true

label:

istio: my-user-gateway

---

istioctl install -y -n istioinaction -f ch4/my-user-gateway.yaml

另一种允许用户创建自己的网关而无需授予他们对 IstioOperator 资源(可以修改现有 Istio 安装)的完全访问权限的方法是通过网关注入。

此方法验证未通过

kubectl apply -f << EOF -

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-user-gateway-injected

namespace: istioinaction

spec:

selector:

matchLabels:

ingress: my-user-gateway-injected

template:

metadata:

annotations:

sidecar.istio.io/inject: "true"

inject.istio.io/templates: gateway

labels:

ingress: my-user-gateway-injected

spec:

containers:

- name: istio-proxy

image: auto

---

apiVersion: v1

kind: Service

metadata:

name: my-user-gateway-injected

namespace: istioinaction

spec:

type: LoadBalancer

selector:

ingress: my-user-gateway-injected

ports:

- port: 80

name: http

- port: 443

name: https

---

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

name: my-user-gateway-injected-sds

namespace: istioinaction

rules:

- apiGroups: [""]

resources: ["secrets"]

verbs: ["get", "watch", "list"]

---

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: my-user-gateway-injected-sds

namespace: istioinaction

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: my-user-gateway-injected-sds

subjects:

- kind: ServiceAccount

name: default

EOF

Ingress网关访问日志#

kubectl -n istio-system logs deploy/istio-ingressgateway

# 生产 Istio 安装禁用了 Access 日志记录。但是,您可以通过将 accessLogFile 属性设置为打印到标准输出流来更改此设置

istioctl install --set meshConfig.accessLogFile=/dev/stdout

# 默认情况下,Access 日志是关闭的,考虑到生产集群有数百或数千个工作负载,每个工作负载都处理大量流量,这是有道理的。

# 要仅显示入口网关工作负载的访问日志,您可以使用以下 Telemetry 配置:

apiVersion: telemetry.istio.io/v1alpha1

kind: Telemetry

metadata:

name: ingress-gateway

namespace: istio-system

spec:

selector:

matchLabels:

app: istio-ingressgateway ❶ 与标签匹配的 Pod 获得遥测配置。

accessLogging:

- providers:

- name: envoy ❷ 访问日志记录的提供者配置

disabled: false ❸ 通过设置disabled为false来启用

telemetry 存在优先级

- Mesh-wide: 配置应用于整个网格中的工作负载。网格范围的配置必须应用在 Istio 安装命名空间中,并且缺少工作负载选择器。

- Namespace-wide: 配置应用于命名空间中的所有工作负载。命名空间范围的配置应用于我们想要配置的工作负载的命名空间,并且还缺少工作负载选择器。这会覆盖应用于工作负载的任何网格范围配置。

- Workload-specific: 配置仅适用于与应用配置的命名空间中的工作负载选择器匹配的工作负载(如前面的代码所示)。特定于工作负载的配置会覆盖网格范围和命名空间范围的配置。

当您部署新网关(例如入口网关)时,代理将配置有可用于网格中路由的所有服务。如前所述,这可能会导致非常大的配置并对网关造成压力。

诀窍是通过仅包含与网关相关的配置来删除代理的任何其他配置。直到最近,此功能还是默认关闭的。在较新的版本中,您可以仔细检查它是否已启用。

PILOT_FILTER_GATEWAY_CLUSTER_CONFIG参考文档:

- https://istio.io/latest/docs/setup/additional-setup/customize-installation/

- https://istio.io/latest/docs/reference/commands/pilot-agent/

- https://zhuanlan.zhihu.com/p/436796453

kubectl get IstioOperator installed-state -o yaml -n istio-system|grep 'PILOT_FILTER_GATEWAY_CLUSTER_CONFIG' kubectl get IstioOperator installed-state -o yaml -n istio-system|grep 'ISTIO_META_DNS_CAPTURE' # 1.17.6 中默认关闭 apiVersion: install.istio.io/v1alpha1 kind: IstioOperator metadata: name: control-plane spec: profile: minimal components: pilot: k8s: env: - name: PILOT_FILTER_GATEWAY_CLUSTER_CONFIG value: "true" meshConfig: defaultConfig: proxyMetadata: ISTIO_META_DNS_CAPTURE: "true" enablePrometheusMerge: true

流量控制#

始之前,让我们先清理一下我们的环境,这样我们就可以从头开始。

kubectl config set-context $(kubectl config current-context) \

--namespace=istioinaction

kubectl delete deployment,svc,gateway,\

virtualservice,destinationrule --all -n istioinaction

蓝绿发布#

# catalog 服务的 v1

kubectl apply -f services/catalog/kubernetes/catalog.yaml

# 创建 暴露网关

kubectl apply -f ch5/catalog-gateway.yaml

# 创建 VirtualService

kubectl apply -f ch5/catalog-vs.yaml

# 测试

curl -I http://192.168.8.212/items -H "Host: catalog.istioinaction.io"

HTTP/1.1 200 OK

x-powered-by: Express

vary: Origin, Accept-Encoding

access-control-allow-credentials: true

cache-control: no-cache

pragma: no-cache

expires: -1

content-type: application/json; charset=utf-8

content-length: 502

etag: W/"1f6-ih2h+hDQ0yLLcKIlBvwkWbyQGK4"

date: Thu, 28 Sep 2023 12:37:28 GMT

x-envoy-upstream-service-time: 2

server: istio-envoy

# 部署 V2

kubectl apply -f services/catalog/kubernetes/catalog-deployment-v2.yaml

# 请求 10 次

for in in {1..10}; do curl http://192.168.8.212/items \

-H "Host: catalog.istioinaction.io"; printf "\n\n"; done

# 将所有流量路由到目录服务的 v1

# 1. 创建 DestinationRule,Deplyment 分别配置 app & version 标签

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: catalog

spec:

host: catalog

subsets:

- name: version-v1

labels:

version: v1

- name: version-v2

labels:

version: v2

# 2 流量全部指向 v1 ,配置 v2 则流量全部前往 v2

- route:

- destination:

host: catalog

subset: version-v1 ❶

kubectl apply -f ch5/catalog-vs-v1.yaml

kubectl apply -f ch5/catalog-vs-v2.yaml

金丝雀发布#

使用请求头实现,

包含 HTTP 标头

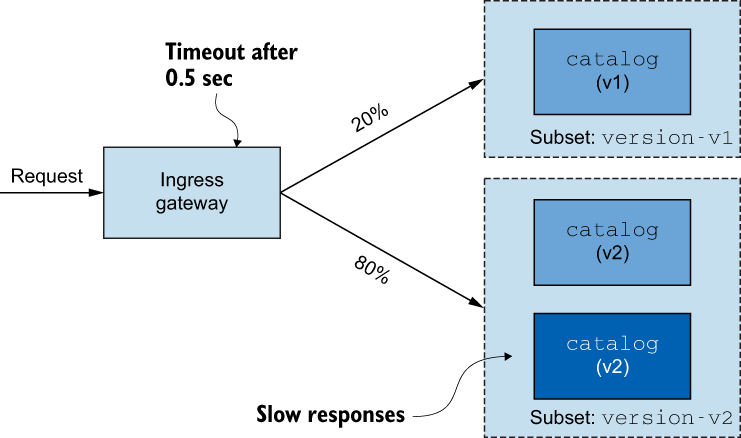

x-istio-cohort: internal的任何流量路由到catalog的 v2apiVersion: networking.istio.io/v1alpha3 kind: VirtualService metadata: name: catalog-vs-from-gw spec: hosts: - "catalog.istioinaction.io" gateways: - catalog-gateway http: - match: - headers: x-istio-cohort: exact: "internal" route: - destination: host: catalog subset: version-v2 - route: - destination: host: catalog subset: version-v1 --- curl http://192.168.8.212/items \ -H "Host: catalog.istioinaction.io" -H "x-istio-cohort: internal"按流量比例实现

- 您可以为每个服务版本在 1 到 100 之间调整流量,

但所有权重的总和必须等于 100。如果不等于 100,可能会发生不可预测的流量路由。 - 如果您有 v1 和 v2 以外的版本,则必须在

DestinationRule中将它们声明为subsets。

kubectl delete gateway,virtualservice,destinationrule --all kubectl apply -f services/webapp/kubernetes/webapp.yaml kubectl apply -f services/webapp/istio/webapp-catalog-gw-vs.yaml kubectl get pod -w kubectl apply -f ch5/catalog-dest-rule.yaml kubectl apply -f ch5/catalog-vs-v1-mesh.yaml kubectl apply -f ch5/catalog-vs-v2-request-mesh.yaml # 让我们将 10% 的流量路由到 catalog 的 v2 : apiVersion: networking.istio.io/v1alpha3 kind: VirtualService metadata: name: catalog spec: hosts: - catalog gateways: - mesh http: - route: - destination: host: catalog subset: version-v1 weight: 90 ❶ - destination: host: catalog subset: version-v2 weight: 10 ❷ --- for for in in {1..100}; do curl -s http://192.168.8.212/api/catalog \ -H "Host: webapp.istioinaction.io"|grep -i imageUrl; done|wc -l 12- 您可以为每个服务版本在 1 到 100 之间调整流量,

金丝雀 配合 Flagger 一起发布#

- https://flagger.app/

- 为了让 Flagger 使用任何成功指标,我们需要安装

Prometheus并抓取 Istio 数据平面。已安装跳过

文档: https://docs.flagger.app/tutorials/istio-progressive-delivery

在此 Canary 资源中,我们指定哪个 Kubernetes Deployment 应作为金丝雀的目标、应自动创建哪些 Kubernetes Service 和 Istio VirtualService 以及如何继续金丝雀。 Canary 资源的最后一部分描述了推广金丝雀的速度、需要关注哪些指标来确定可行性以及确定成功的阈值。我们每 45 秒评估一次金丝雀步骤,每一步增加 10% 的流量;当流量达到 50% 时,我们将流量削减至 100%。

- 对于成功率指标,我们只能容忍 1 分钟内 99% 的成功检查。我们还只允许 P99(第 99 个百分位)的请求持续时间为 500 毫秒。如果这些指标偏离我们指定的值超过五个时间间隔,金丝雀将被停止并回滚。

- 在此期间您可以检查金丝雀的状态,如存在问题时,可检查 flagger 中日志, 或执行

kubectl describe canary catalog-release

- 此时,Flagger 已自动创建驱动金丝雀版本所需的一些 Kubernetes 资源,例如 Deployment 、 Service 和 VirtualService 对象。

kubectl get virtualservice catalog -o yaml

# 清理环境

kubectl delete vs,svc,deploy,destinationrule \

--all -n istioinaction

kubectl delete -f ch5/flagger

# 部署应用

kubectl config set-context $(kubectl config current-context) \

--namespace=istioinaction

kubectl apply -f ./ch5/flagger/catalog-deployment-v1.yaml

# 创建 mesh 网关

kubectl apply -f << EOF -

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: mesh

namespace: istioinaction

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "*"

EOF

# 部署 prometheus

kubectl apply -f https://raw.githubusercontent.com/istio/istio/release-1.19/samples/addons/prometheus.yaml

# 使用 helm 安装 Flagger

helm repo add flagger https://flagger.app

kubectl apply -f \

https://raw.githubusercontent.com/fluxcd/flagger/main/artifacts/flagger/crd.yaml

helm install flagger flagger/flagger \

--namespace=istio-system \

--set crd.create=false \

--set meshProvider=istio \

--set metricsServer=http://prometheus:9090

# CRD 清单

apiVersion: flagger.app/v1beta1

kind: Canary

metadata:

name: catalog-release

namespace: istioinaction

spec:

targetRef: ❶ 部署到金丝雀

apiVersion: apps/v1

kind: Deployment

name: catalog

progressDeadlineSeconds: 60

# Service / VirtualService Config

service: ❷ 服务配置

name: catalog

port: 80

targetPort: 3000

gateways:

- mesh

hosts:

- catalog

analysis: ❸ 金丝雀进展参数

interval: 45s

threshold: 5

maxWeight: 50

stepWeight: 10

metrics:

- name: request-success-rate

thresholdRange:

min: 99

interval: 1m

- name: request-duration

thresholdRange:

max: 500

interval: 30s

# 在此 Canary 资源中,我们指定哪个 Kubernetes Deployment 应作为金丝雀的目标、应自动创建哪些 Kubernetes Service 和 Istio VirtualService 以及如何继续金丝雀。 Canary 资源的最后一部分描述了推广金丝雀的速度、需要关注哪些指标来确定可行性以及确定成功的阈值。我们每 45 秒评估一次金丝雀步骤,每一步增加 10% 的流量;当流量达到 50% 时,我们将流量削减至 100%。

# - 对于成功率指标,我们只能容忍 1 分钟内 99% 的成功检查。我们还只允许 P99(第 99 个百分位)的请求持续时间为 500 毫秒。如果这些指标偏离我们指定的值超过五个时间间隔,金丝雀将被停止并回滚。

kubectl apply -f << EOF -

apiVersion: flagger.app/v1beta1

kind: Canary

metadata:

name: catalog-release

namespace: istioinaction

spec:

targetRef:

apiVersion: apps/v1

kind: Deployment

name: catalog

progressDeadlineSeconds: 60

# Service / VirtualService Config

service:

name: catalog

port: 80

targetPort: 3000

gateways:

- public-gateway.istio-system.svc.cluster.local

hosts:

- test.example.com

analysis:

interval: 45s

threshold: 5

maxWeight: 50

stepWeight: 10

metrics:

- name: request-success-rate

thresholdRange:

min: 99

interval: 1m

- name: request-duration

thresholdRange:

max: 500

interval: 30s

EOF

# 更新镜像,触发更新

kubectl -n istioinaction set image deployment/catalog \

catalog=yangzun/istio-catalog:latest

# 在此期间您可以检查金丝雀的状态,如存在问题时,可检查 flagger 中日志, 或执行 kubectl describe canary catalog-release

kubectl get canary catalog-release -w

# 此时,Flagger 已自动创建驱动金丝雀版本所需的一些 Kubernetes 资源,例如 Deployment 、 Service 和 VirtualService 对象。

kubectl get virtualservice catalog -o yaml

kubectl get gw -o yaml

# 滚动更新时,需要有流量请求,来触发 analysis 中的阈值更新。请求网关地址时,需要正确可以路由到后端

while true; do curl "http://192.168.8.212" \

-H "Host: test.example.com" ; sleep 1; done

curl -s http://192.168.8.212 -H "Host: test.example.com"

kubectl apply -f << EOF -

apiVersion: networking.istio.io/v1alpha3

kind: Gateway

metadata:

name: public-gateway

namespace: istio-system

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "*"

EOF

kubectl create ns test

kubectl label namespace test istio-injection=enabled

kubectl apply -k https://github.com/fluxcd/flagger//kustomize/podinfo?ref=main

kubectl apply -k https://github.com/fluxcd/flagger//kustomize/tester?ref=main

kubectl apply -f << EOF -

apiVersion: flagger.app/v1beta1

kind: Canary

metadata:

name: podinfo

namespace: test

spec:

# deployment reference

targetRef:

apiVersion: apps/v1

kind: Deployment

name: podinfo

# the maximum time in seconds for the canary deployment

# to make progress before it is rollback (default 600s)

progressDeadlineSeconds: 60

# HPA reference (optional)

autoscalerRef:

apiVersion: autoscaling/v2beta2

kind: HorizontalPodAutoscaler

name: podinfo

service:

# service port number

port: 9898

# container port number or name (optional)

targetPort: 9898

# Istio gateways (optional)

gateways:

- public-gateway.istio-system.svc.cluster.local

# Istio virtual service host names (optional)

hosts:

- app.example.com

# Istio traffic policy (optional)

trafficPolicy:

tls:

# use ISTIO_MUTUAL when mTLS is enabled

mode: DISABLE

# Istio retry policy (optional)

retries:

attempts: 3

perTryTimeout: 1s

retryOn: "gateway-error,connect-failure,refused-stream"

analysis:

# schedule interval (default 60s)

interval: 1m

# max number of failed metric checks before rollback

threshold: 5

# max traffic percentage routed to canary

# percentage (0-100)

maxWeight: 50

# canary increment step

# percentage (0-100)

stepWeight: 10

metrics:

- name: request-success-rate

# minimum req success rate (non 5xx responses)

# percentage (0-100)

thresholdRange:

min: 99

interval: 1m

- name: request-duration

# maximum req duration P99

# milliseconds

thresholdRange:

max: 500

interval: 30s

# testing (optional)

webhooks:

- name: acceptance-test

type: pre-rollout

url: http://flagger-loadtester.test/

timeout: 30s

metadata:

type: bash

cmd: "curl -sd 'test' http://podinfo-canary:9898/token | grep token"

- name: load-test

url: http://flagger-loadtester.test/

timeout: 5s

metadata:

cmd: "hey -z 1m -q 10 -c 2 http://podinfo-canary.test:9898/"

EOF

# 更新镜像触发金丝雀更新

kubectl -n test set image deployment/podinfo \

podinfod=ghcr.io/stefanprodan/podinfo:6.0.1

# 查看正在进行的所有 金丝雀

watch kubectl get canaries --all-namespaces

curl -s http://192.168.8.212 -H "Host: app.example.com"

流量镜像#

https://istio.io/latest/docs/tasks/traffic-management/mirroring/

集群流量安全#

运行以下命令将 Istio 的默认值从

ALLOW_ANY更改为REGISTRY_ONLY。这意味着只有在服务网格注册表中明确将流量列入白名单时,我们才会允许流量离开网格istioctl install --set profile=demo \ --set meshConfig.outboundTrafficPolicy.mode=REGISTRY_ONLYServiceEntry

可以指定 ServiceEntry 资源,用于增强外部服务并将其插入 Istio 白名单注册表,白名单。

# 此 ServiceEntry 资源会在 Istio 的服务注册表中插入一个条目,明确规定允许网格中的客户端使用主机 jsonplaceholder.typicode.com 调用 JSON 占位符。 apiVersion: networking.istio.io/v1alpha3 kind: ServiceEntry metadata: name: jsonplaceholder spec: hosts: - jsonplaceholder.typicode.com ports: - number: 80 name: http protocol: HTTP resolution: DNS location: MESH_EXTERNAL kubectl apply -f services/forum/kubernetes/forum-all.yaml kubectl apply -f ch5/forum-serviceentry.yaml

恢复能力:解决应用网络挑战#

弹性模式#

- Istio 的服务代理实现了这些开箱即用的基本弹性模式:

- 客户端负载平衡 Client-side load balancing

- 本地感知负载平衡 Locality-aware load balancing

- Circuit breaking 熔断

- Timeouts and retries 超时和重试

客户端负载平衡#

ROUND_ROBIN 是默认的负载均衡算法

kubectl config set-context $(kubectl config current-context) \

--namespace=istioinaction

kubectl delete virtualservice,deployment,service,\

destinationrule,gateway --all

kubectl apply -f ch6/simple-backend.yaml

kubectl apply -f ch6/simple-web.yaml

kubectl apply -f ch6/simple-web-gateway.yaml

# 用 Istio DestinationRule 资源为调用 simple-backend 服务的任何客户端指定 ROUND_ROBIN 负载平衡。

curl -s -H "Host: simple-web.istioinaction.io" http://192.168.8.212

for in in {1..10}; do \

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq ".upstream_calls[0].body"; printf "\n"; done

Fortio 负载测试库#

# 安装

brew install fortio

# 运行

kubectl -n default run fortio --image=fortio/fortio:1.60.2 \

--restart='Never' -- load -H "Host: simple-web.istioinaction.io" \

-jitter -t 60s -c 10 -qps 1000 \

http://192.168.8.212

测试结果

最少连接比随机连接和循环连接的性能都要好- 最少连接负载平衡器(在 Envoy 中以最少请求方式实现)会考虑特定端点的延迟。

- 它会监控队列深度,跟踪活动请求,并选择飞行中活动请求最少的端点。利用这种算法,我们可以避免向行为不佳的端点发送请求,而选择响应速度更快的端点。

- 尽管 Istio 配置将最少请求负载平衡称为

LEAST_CONN,但 Envoy 追踪的是端点而非连接的请求深度。

本地感知负载平衡#

Istio 支持一种负载平衡类型,可根据特定工作负载的位置为路由赋予权重并做出路由决策。Istio 可以识别部署特定服务的区域和可用性区域,并优先考虑距离较近的服务。

实践#

节点标注

分别指定地区和区域 - 标签

failure-domain.beta.kubernetes.io/regionfailure-domain.beta.kubernetes.io/zone

在 Kubernetes API 最近的通用版本中,这些标签已被

topology.kubernetes.io/region和topology.kubernetes.io/zone所取代。云供应商仍在使用较旧的failure-domain标签。Istio可同时查找这两种标签。

POD 标注

我们可以用

istio-locality标记我们的 Podspec: replicas: 1 selector: matchLabels: app: simple-web template: metadata: labels: app: simple-web istio-locality: us-west1.us-west1-a ❶

验证

默认情况下,Istio 的服务代理会将所有流量发送到同一本地的服务,只有当出现故障或端点不健康时才会溢出。

# Case-1 当 backend-1 存在故障时,将流量切换至 backend-2

kubectl apply -f ch6/simple-service-locality.yaml

for in in {1..10}; do \

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq ".upstream_calls[0].body"; printf "\n"; done

# 在 Istio 中实现本地感知负载均衡,我们还需要配置最后一块拼图:健康检查。

kubectl apply -f ch6/simple-backend-dr-outlier.yaml

for in in {1..10}; do \

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq ".upstream_calls[0].body"; printf "\n"; done

# 将 backend-1 设置为故障

for for in in {1..10}; do \

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq ".upstream_calls[0].body"; printf "\n"; done

null

"Hello from simple-backend-2"

"Hello from simple-backend-2"

"Hello from simple-backend-2"

"Hello from simple-backend-2"

"Hello from simple-backend-2"

"Hello from simple-backend-2"

"Hello from simple-backend-2"

"Hello from simple-backend-2"

"Hello from simple-backend-2"

利用加权分布对本地负载平衡进行更多控制

# 为了完成这一配置,我们在 DestinationRule 资源中指定了本地化负载均衡首选项:

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

metadata:

name: simple-backend-dr

spec:

host: simple-backend.istioinaction.svc.cluster.local

trafficPolicy:

loadBalancer: ❶ 添加负载平衡器配置

localityLbSetting:

distribute:

- from: us-west1/us-west1-a/* ❷ 来自的区域

to:

"us-west1/us-west1-a/*": 70 ❸ 目的地区域

"us-west1/us-west1-b/*": 30 ❹ 目的地区域

connectionPool:

http:

http2MaxRequests: 10

maxRequestsPerConnection: 10

outlierDetection:

consecutive5xxErrors: 1

interval: 5s

baseEjectionTime: 30s

# 应用

kubectl apply -f ch6/simple-backend-dr-outlier-locality.yaml

for for in in {1..10}; do \

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq ".upstream_calls[0].body"; printf "\n"; done

null

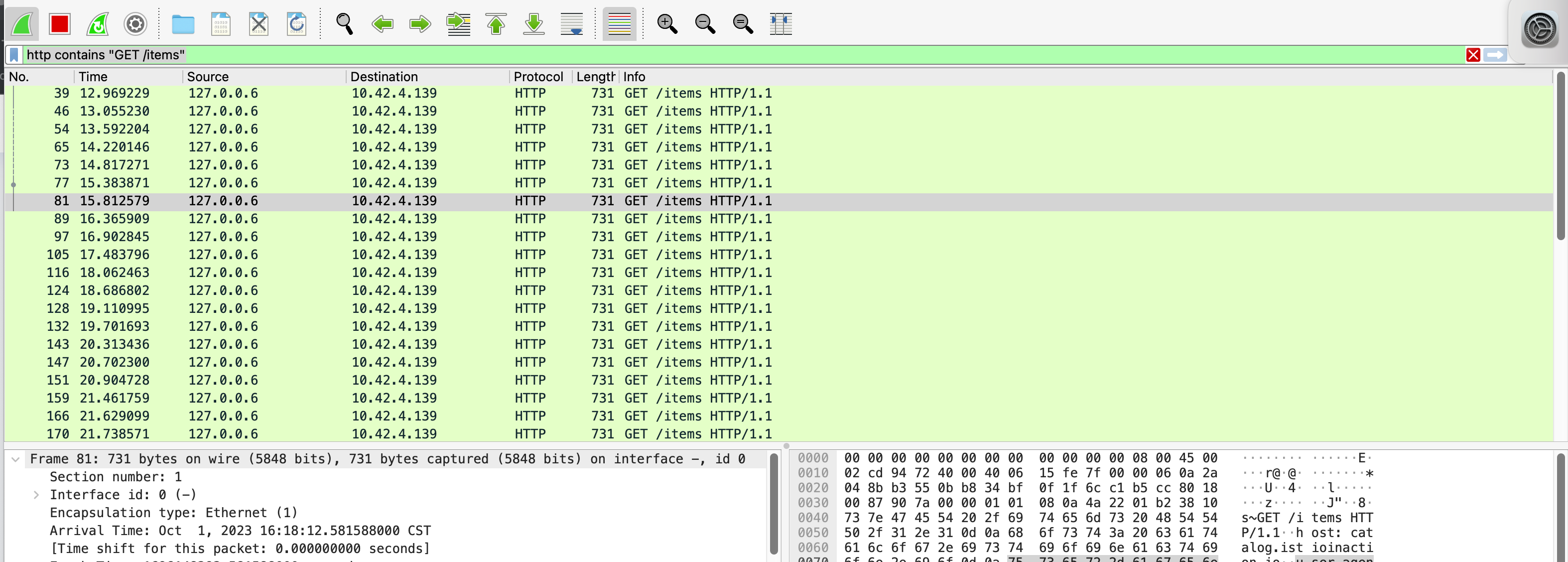

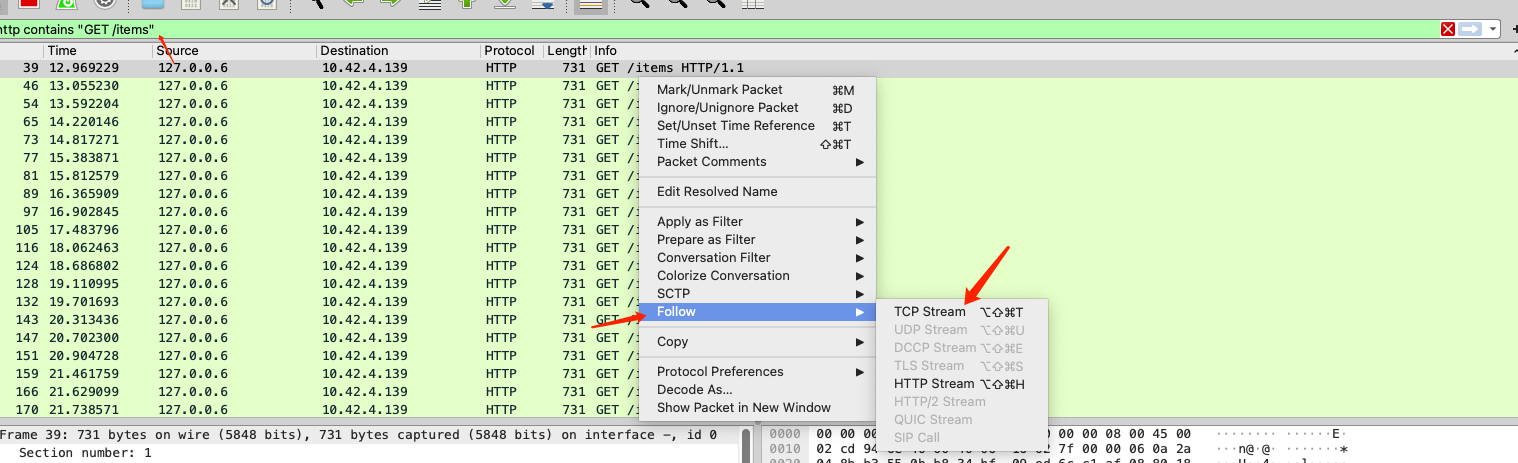

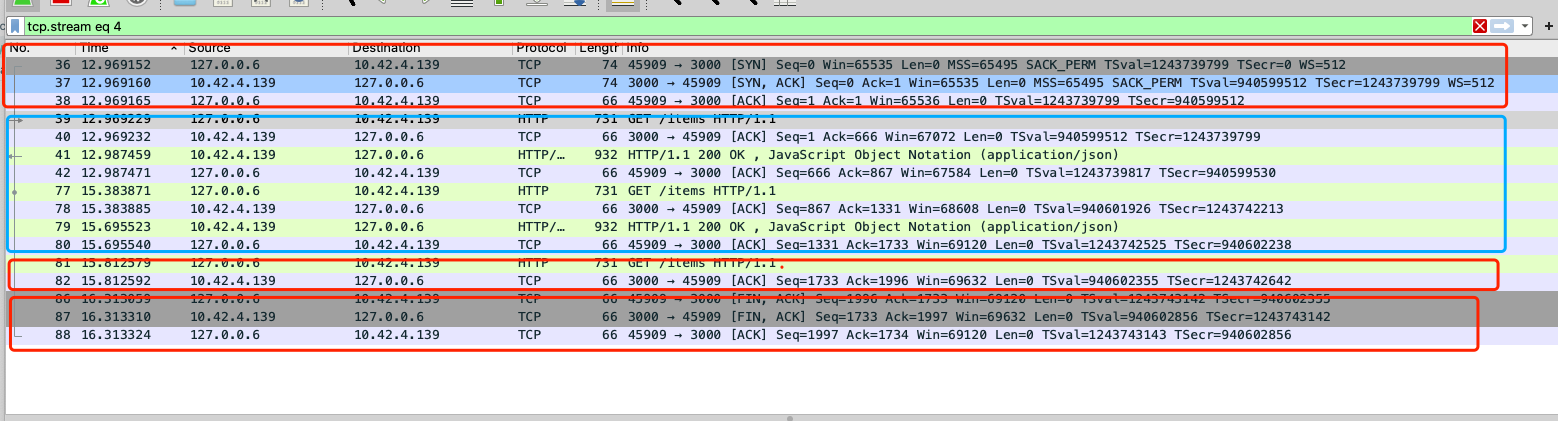

透明超时和重试#

在构建依赖分布在网络上的组件的系统时,最大的问题包括延迟和故障。

分布式环境中最难处理的情况之一就是延迟。当运行速度减慢时,资源可能会被占用更长时间,服务可能会出现倒退,这种情况有可能引发连锁故障。

# 重置集群

kubectl apply -f ch6/simple-web.yaml

kubectl apply -f ch6/simple-backend.yaml

kubectl delete destinationrule simple-backend-dr

for in in {1..10}; do time curl -s \

-H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq .code; printf "\n"; done

# 部署一个 simple-backend 服务版本,为该实例的 50% 调用插入一秒钟的处理延迟:

kubectl apply -f ch6/simple-backend-delayed.yaml

# 再次请求,有些请求需要一秒钟或更长的时间:

for in in {1..10}; do time curl -s \

-H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq .code; printf "\n"; done

200

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.00s user 0.00s system 0% cpu 1.068 total

jq .code 0.01s user 0.00s system 1% cpu 1.068 total

200

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.00s user 0.01s system 0% cpu 1.035 total

jq .code 0.02s user 0.00s system 1% cpu 1.034 total

200

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.01s user 0.01s system 5% cpu 0.194 total

jq .code 0.03s user 0.00s system 13% cpu 0.194 total

---

# 在 VirtualService 中指定超时时间

http:

- route:

- destination:

host: simple-backend

timeout: 0.5s ❶ 指定超时值

# 应用

kubectl apply -f ch6/simple-backend-vs-timeout.yaml

# 再次请求,此时大于 0.5s 的请求,会被判断为 500错误

for for in in {1..10}; do time curl -s \

-H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq .code; printf "\n"; done

200

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.00s user 0.00s system 4% cpu 0.176 total

jq .code 0.02s user 0.00s system 10% cpu 0.175 total

500

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.01s user 0.01s system 2% cpu 0.550 total

jq .code 0.02s user 0.00s system 4% cpu 0.549 total

200

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.01s user 0.01s system 6% cpu 0.188 total

jq .code 0.02s user 0.00s system 14% cpu 0.187 total

重试

# Reset

kubectl apply -f ch6/simple-web.yaml

kubectl apply -f ch6/simple-backend.yaml

# Istio 默认启用了重试功能,最多重试两次。让我们禁用示例应用程序的默认重试, 将最大重试次数设置为 0

istioctl install --set profile=demo \

--set meshConfig.defaultHttpRetryPolicy.attempts=0

# 部署一个有周期性(75%)故障的 simple-backend 服务版本。

kubectl apply -f ch6/simple-backend-periodic-failure-503.yaml

# 执行 多次调用该服务

for in in {1..10}; do curl -s \

-H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq .code; printf "\n"; done

200

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.00s user 0.00s system 3% cpu 0.176 total

jq .code 0.01s user 0.00s system 8% cpu 0.175 total

500

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.00s user 0.01s system 31% cpu 0.034 total

jq .code 0.02s user 0.00s system 74% cpu 0.033 total

500

curl -s -H "Host: simple-web.istioinaction.io" 192.168.8.212 0.00s user 0.00s system 27% cpu 0.024 total

jq .code 0.02s user 0.00s system 73% cpu 0.023 total

# 调用 simple-backend 时的重试尝试明确配置为 2

http:

- route:

- destination:

host: simple-backend

retries:

attempts: 2

kubectl apply -f ch6/simple-backend-enable-retry.yaml

# 再次查看

for in in {1..10}; do curl -s \

-H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq .code; printf "\n"; done

200

200

200

# 启用了 Istio 的重试策略来解决这些错误。默认情况下,HTTP 503 是可重试状态代码之一。

# 下面的 VirtualService 重试策略显示了重试时可配置的参数:

http:

- route:

- destination:

host: simple-backend

retries:

attempts: 2 ❶

retryOn: gateway-error,connect-failure,retriable-4xx ❷

perTryTimeout: 300ms ❸

retryRemoteLocalities: true ❹

❶ 最大重试次数

❷ 需要重试的错误

❸ 超时

❹是否重试其他地区的端点

# 部署的 simple-backend 服务返回 HTTP 500 代码,默认重试行为将无法捕获

for in in {1..10}; do curl -s \

-H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq .code; printf "\n"; done

200

200

200

200

200

200

200

200

500

200

# 使用 VirtualService 重试策略,重试所有 HTTP 500 代码(包括 connect-failure 和 refused-stream )

http:

- route:

- destination:

host: simple-backend

retries:

attempts: 2

retryOn: 5xx ❶

kubectl apply -f ch6/simple-backend-vs-retry-500.yaml

# 此时执行,将不存在 500 异常

for in in {1..10}; do curl -s \

-H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq .code; printf "\n"; done

200

200

200

200

200

200

200

200

200

200

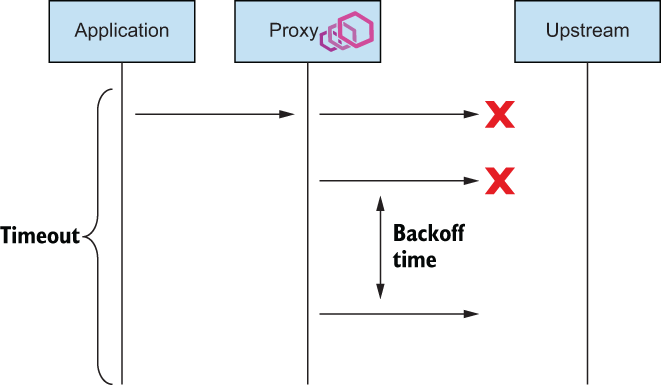

超时计算的重试次数 & 原理#

每次重试都有自己的

perTryTimeout,perTryTimeout值乘以总尝试次数必须小于总请求超时- 例如,总超时时间为一秒,重试策略为三次,每次重试超时时间为 500 毫秒,这样的设置是行不通的。

当请求流经 Istio 服务代理时,如果

未能向上游交付,则会被标记为失败并重试,重试次数最多可达VirtualService资源中定义的最大attempts字段。- 意味着当

attempts值为2时的情况下,请求最多会被交付三次:原始请求一次,重试两次。

- 意味着当

Istio 将以 25 毫秒为基数 “后退 “重试。

- 这意味着每次连续重试时,Istio 都会后退(等待)至(25 毫秒 x 尝试次数 #),以错开重试时间。

- 重试基础是固定的

请求失败时重试的请求流程

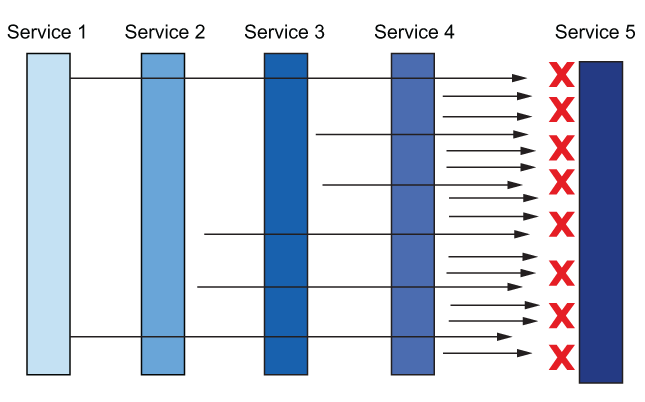

Istio 默认将重试

attempts设置为2。.您可能希望覆盖此设置,以便系统的不同层重试不同次数。天真的重试设置(如默认设置)会导致严重的重试 “thundering herd “问题例如,如果一个服务链有 5 个深度调用,每个步骤可以重试请求 2 次,那么每个传入请求可能会有

32 个请求。如果服务链末端的资源超载,这些额外的负载可能会使目标资源不堪重负,以至于崩溃。这些额外的负载可能会使目标资源不堪重负,以至于崩溃。处理这种情况的一种方法是,将架构边缘的重试尝试限制为一次或零次,只在调用栈深处重试,中间组件不重试。

这可能也不会有很好的效果。另一种策略是对总重试次数设置上限。我们可以通过重试预算来做到这一点,但 Istio API 还没有公开预算。- Istio 中存在解决这一问题的变通方法,

但不在本书讨论范围之内

- Istio 中存在解决这一问题的变通方法,

重试相互复合时的 “thundering herd “效应

- 默认情况下,将尝试对本地区的端点进行重试。retryRemoteLocalities设置会影响此行为:如果将其设置为true,则Istio允许重试溢出到其他地区。在异常检测确定本地首选端点表现不佳之前,这可能非常有用。

高级重试#

默认情况下,回退时间为

25 毫秒,可重试代码仅限于HTTP 503尽管在撰写本文时,Istio API 并未公开这些配置,但我们可以使用 Istio 扩展 API 直接在 Envoy 配置中更改这些值。我们使用EnvoyFilterAPI 来实现

apiVersion: networking.istio.io/v1alpha3

kind: EnvoyFilter

metadata:

name: simple-backend-retry-status-codes

namespace: istioinaction

spec:

workloadSelector:

labels:

app: simple-web

configPatches:

- applyTo: HTTP_ROUTE

match:

context: SIDECAR_OUTBOUND

routeConfiguration:

vhost:

name: "simple-backend.istioinaction.svc.cluster.local:80"

patch:

operation: MERGE

value:

route:

retry_policy: ❶ 直接从Envoy配置中获取

retry_back_off:

base_interval: 50ms ❷ 增加基本间隔

retriable_status_codes: ❸ 添加可重试代码

- 408

- 400

# 应用

kubectl apply -f ch6/simple-backend-ef-retry-status-codes.yaml

# 还希望更新 retryOn 字段,使其包含 retriable-status-codes

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: simple-backend-vs

spec:

hosts:

- simple-backend

http:

- route:

- destination:

host: simple-backend

retries:

attempts: 2

retryOn: 5xx,retriable-status-codes ❶ 包括可重试的状态码

kubectl apply -f ch6/simple-backend-vs-retry-on.yaml

# 更新 sample-backend 服务,使其返回 HTTP 408(超时),并验证是否能继续获得 HTTP 200

kubectl apply -f ch6/simple-backend-periodic-failure-408.yaml

# 验证

for in in {1..10}; do curl -s \

-H "Host: simple-web.istioinaction.io" 192.168.8.212 \

| jq .code; printf "\n"; done

请求对冲#

当请求达到其阈值并超时时,我们可以选择配置Envoy,在底层执行所谓的请求hedging。通过请求hedging,如果一个请求超时了,Envoy可以发送另一个请求到不同的主机上,“竞赛”原始的、超时的请求。在这种情况下,如果竞赛的请求成功返回,则将其响应发送给原始下游调用者。如果原始请求在竞赛请求返回之前返回,则将原始请求返回给下游调用者。

# 要设置请求对冲,我们可以使用以下 EnvoyFilter 资源:

apiVersion: networking.istio.io/v1alpha3

kind: EnvoyFilter

metadata:

name: simple-backend-retry-hedge

namespace: istioinaction

spec:

workloadSelector:

labels:

app: simple-web

configPatches:

- applyTo: VIRTUAL_HOST

match:

context: SIDECAR_OUTBOUND

routeConfiguration:

vhost:

name: "simple-backend.istioinaction.svc.cluster.local:80"

patch:

operation: MERGE

value:

hedge_policy:

hedge_on_per_try_timeout: true

超时和重试的主题并不简单。为服务制定良好的超时和重试策略非常具有挑战性,尤其是考虑到它们是如何串联在一起的。配置错误的超时和重试可能会放大系统架构中的不良行为,以至于使系统超载并引发连锁故障。构建弹性架构的最后一个难题是完全跳过重试:与其重试,不如快速失败。我们可以在一段时间内限制负载,让上游系统恢复,而不是增加负载。为此,我们可以采用熔断技术

使用 Istio 熔断#

使用断路功能来帮助防范部分或级联故障。我们希望

减少进入不健康系统的流量,从而避免这些系统继续超负荷运行,导致无法恢复。这种方法与房屋电气系统中空气开关的工作原理类似。如果系统出现短路或重复故障,空气开关就会保护系统的其他部分。熔断器模式迫使我们的应用程序处理网络调用可能发生故障的事实,并有助于保护整个系统免受连锁故障的影响。

无法正常工作的熔断方法#

如果有十个请求正在向某个服务发送,而且在相同的入站负载量下,请求数量还在不断增加,那么继续发送请求就没有意义了–发送更多请求可能会使上游服务不堪重负。我们使用目标规则中的

connectionPool设置来限制调用服务时可能堆积的连接和请求数量。如果请求堆积过多,我们可以短路(快速失败)并返回客户端。第二种控制方法是观察

负载平衡池中端点的健康状况,并暂时驱逐行为不端的端点。

利用连接池控制防止服务速度过慢

- maxConnections-我们报告连接溢出的阈值。Istio代理(Envoy)使用连接来服务请求,上限由此设置定义。实际上,我们可以预期最大连接数为负载均衡池中每个端点加上此设置的值。每当超过这个值时,Envoy将在其指标中报告。

- http1MaxPendingRequests-允许挂起且没有可用连接的请求数。

- http2MaxRequests-Istio中不幸地命名错误。在底层,它控制着集群中所有端点/主机之间并行请求的最大数量,无论是HTTP2还是HTTP1.1(参见https://github.com/istio/istio/issues/27473)。

# 引入一秒钟的延迟

kubectl apply -f ch6/simple-backend-delayed.yaml

# 删除目的地规则

kubectl delete destinationrule --all

fortio load -H "Host: simple-web.istioinaction.io" \

-quiet -jitter -t 30s -c 1 -qps 1 http://192.168.8.212/

Error cases : count 0 avg 0 +/- 0 min 0 max 0 sum 0

# Socket and IP used for each connection:

[0] 1 socket used, resolved to 192.168.8.212:80, connection timing : count 1 avg 0.000936291 +/- 0 min 0.000936291 max 0.000936291 sum 0.000936291

Sockets used: 1 (for perfect keepalive, would be 1)

Uniform: false, Jitter: true, Catchup allowed: true

IP addresses distribution:

192.168.8.212:80: 1

Code 200 : 30 (100.0 %)

All done 30 calls (plus 1 warmup) 1029.536 ms avg, 1.0 qp

#引入一些连接和请求限制

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

metadata:

name: simple-backend-dr

spec:

host: simple-backend.istioinaction.svc.cluster.local

trafficPolicy:

connectionPool:

tcp:

maxConnections: 1 ❶ 连接总数

http:

http1MaxPendingRequests: 1 ❷ 排队请求

maxRequestsPerConnection: 1 ❸ 每个连接的请求数量

maxRetries: 1

http2MaxRequests: 1 ❹ 所有主机的最大并发请求数量

kubectl apply -f ch6/simple-backend-dr-conn-limit.yaml

fortio load -H "Host: simple-web.istioinaction.io" \

-quiet -jitter -t 30s -c 1 -qps 1 http://192.168.8.212

Code 200 : 30 (100.0 %)

fortio load -H "Host: simple-web.istioinaction.io" \

-quiet -jitter -t 30s -c 2 -qps 2 -allow-initial-errors http://192.168.8.212

Code 200 : 31 (60.8 %)

Code 500 : 20 (39.2 %)

请求返回失败(HTTP 5xx)。我们如何确定这些请求是受断路影响,而不是上游故障?

要确定这些信息,我们需要在 Istio 服务代理中启用更多统计数据收集功能。默认情况下,Istio 的服务代理(Envoy)会为每个群集保存大量统计数据,

但 Istio 会对这些数据进行缩减,以免大量统计数据使收集代理(如Prometheus)不堪重负。为了扩展 Istio 公开的统计数据,尤其是上游断路统计数据,我们在

simple-web中使用了annotationssidecar.istio.io/statsInclusionPrefixes

template: metadata: annotations: sidecar.istio.io/statsInclusionPrefixes: ➥"cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local" labels: app: simple-web

# 在 simple-web 中 应用注释

kubectl apply -f ch6/simple-web-stats-incl.yaml

# 重置 simple-web 服务中 Istio 代理的所有统计数据

kubectl exec -it deploy/simple-web -c istio-proxy \

-- curl -X POST localhost:15000/reset_counters

OK

# 再次产生负载时

fortio load -H "Host: simple-web.istioinaction.io" \

-quiet -jitter -t 30s -c 2 -qps 2 -allow-initial-errors http://192.168.8.212

Code 200 : 30 (55.6 %)

Code 500 : 24 (44.4 %)

# 运行下面的查询

kubectl exec -it deploy/simple-web -c istio-proxy \

-- curl localhost:15000/stats | grep simple-backend | grep overflow

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_cx_overflow: 53

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_cx_pool_overflow: 0

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_rq_pending_overflow: 25

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_rq_retry_overflow: 0

# upstream_cx_overflow 和 upstream_rq_pending_overflow 。这表明有足够多的连接和请求超过了我们指定的阈值(并行请求过多或排队请求过多),导致空气开关跳闸。

# 增加 http2MaxRequests 字段,以应对并行发生的更多请求呢?让我们将该值提高到 2 重置计数器,然后重新运行负载测试

kubectl patch destinationrule simple-backend-dr --type merge \

--patch \

'{"spec": {"trafficPolicy": {"connectionPool": {

"http": {"http2MaxRequests": 2}}}}}'

kubectl exec -it deploy/simple-web -c istio-proxy \

-- curl -X POST localhost:15000/reset_counters

fortio load -H "Host: simple-web.istioinaction.io" \

-quiet -jitter -t 30s -c 2 -qps 2 -allow-initial-errors http://192.168.8.212

Code 200 : 31 (100.0 %)

# 熔断而受阻的请求减少:

kubectl exec -it deploy/simple-web -c istio-proxy \

-- curl localhost:15000/stats | grep simple-backend | grep overflow

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_cx_overflow: 35

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_cx_pool_overflow: 0

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_rq_pending_overflow: 1

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_rq_retry_overflow: 0

# 将待处理队列深度增加到 2

kubectl patch destinationrule simple-backend-dr --type merge \

--patch \

'{"spec": {"trafficPolicy": {"connectionPool": {

"http": {"http1MaxPendingRequests": 2}}}}}'

kubectl exec -it deploy/simple-web -c istio-proxy \

-- curl -X POST localhost:15000/reset_counters

fortio load -H "Host: simple-web.istioinaction.io" \

-quiet -jitter -t 30s -c 2 -qps 2 -allow-initial-errors http://192.168.8.212

Code 200 : 32 (100.0 %)

# 此时发生触发熔断重试为 0

kubectl exec -it deploy/simple-web -c istio-proxy \

-- curl localhost:15000/stats | grep simple-backend | grep overflow

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_cx_overflow: 41

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_cx_pool_overflow: 0

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_rq_pending_overflow: 0

cluster.outbound|80||simple-backend.istioinaction.svc.cluster.local.upstream_rq_retry_overflow: 0

upstream_rq_retry_overflow :由于断路器触发或超出重试预算,未重新尝试的总请求数量。

upstream_cx_overflow :集群连接断路器溢出的总次数

更多参数详情请参考: https://www.envoyproxy.io/docs/envoy/latest/configuration/upstream/cluster_manager/cluster_stats

当请求因触及断路阈值而失败时,Istio 的服务代理会添加一个 x-envoy-overloaded 头信息。

...

"upstream_calls": [

{

"uri": "http://simple-backend:80/",

"headers": {

"Content-Length": "81",

"Content-Type": "text/plain",

"Date": "Tue, 22 Sep 2020 20:01:44 GMT",

"Server": "envoy",

"x-envoy-overloaded": "true" ❶

},

...

通过异常值检测来防范不健康的服务#

配置参考文档: https://istio.io/latest/docs/reference/config/networking/destination-rule/

kubectl apply -f ch6/simple-backend.yaml

kubectl delete destinationrule --all

kubectl apply -f ch6/simple-web-stats-incl.yaml

# 禁用整个网格的重试功能, 删除任何已配置重试的 VirtualService 资源

istioctl install --set profile=demo \

--set meshConfig.defaultHttpRetryPolicy.attempts=0

kubectl delete vs simple-backend-vs

# 75% 的 simple-backend-1 端点调用都会以 HTTP 500 失败

kubectl apply -f ch6/simple-backend-periodic-failure-500.yaml

fortio load -H "Host: simple-web.istioinaction.io" \

-allow-initial-errors -quiet -jitter -t 30s -c 10 -qps 20 -allow-initial-errors http://192.168.8.212

Sockets used: 304 (for perfect keepalive, would be 10)

Uniform: false, Jitter: true, Catchup allowed: true

IP addresses distribution:

Code 200 : 304 (50.7 %)

Code 500 : 296 (49.3 %)

# 配置离群点检测 示例

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

metadata:

name: simple-backend-dr

spec:

host: simple-backend.istioinaction.svc.cluster.local

trafficPolicy:

outlierDetection:

consecutive5xxErrors: 1 # 配置为 1 值。这意味着异常点检测只会在一个坏请求后跳闸

interval: 5s # 设置指定 Istio 服务代理检查主机的频率,并根据 consecutive5xxErrors 设置决定是否弹出端点。

baseEjectionTime: 5s # 如果服务端点被弹出,则弹出时间为 n * baseEjectionTime 。其中 n 是该端点被弹出的次数。时间结束后,该端点将重新加入负载平衡池。

maxEjectionPercent: 100 # 上游服务负载均衡池中可被剔除的最大主机百分比。默认为10%。

kubectl apply -f ch6/simple-backend-dr-outlier-5s.yaml

fortio load -H "Host: simple-web.istioinaction.io" \

-allow-initial-errors -quiet -jitter -t 30s -c 10 -qps 20 -allow-initial-errors http://192.168.8.212

Code 200 : 581 (96.8 %)

Code 500 : 19 (3.2 %)

# 由于行为不端的端点被弹出一段时间,我们的错误率大幅降低。不过,我们仍有 19 次调用失败。为了证明这些错误是由行为不端的端点造成的,我们可以检查统计数据:

kubectl exec -it deploy/simple-web -c istio-proxy -- \

curl localhost:15000/stats | grep simple-backend | grep outlier

# simple-backend-1 主机被弹出三次。

# 添加默认重试设置,解决最后几个错误。我们可以添加默认重试设置为,总计3。

istioctl install --set profile=demo \

--set meshConfig.defaultHttpRetryPolicy.attempts=2

# vs 重建一下,再次执行测试

fortio load -H "Host: simple-web.istioinaction.io" \

-allow-initial-errors -quiet -jitter -t 30s -c 10 -qps 20 -allow-initial-errors http://192.168.8.212

Code 200 : 600 (100.0 %)

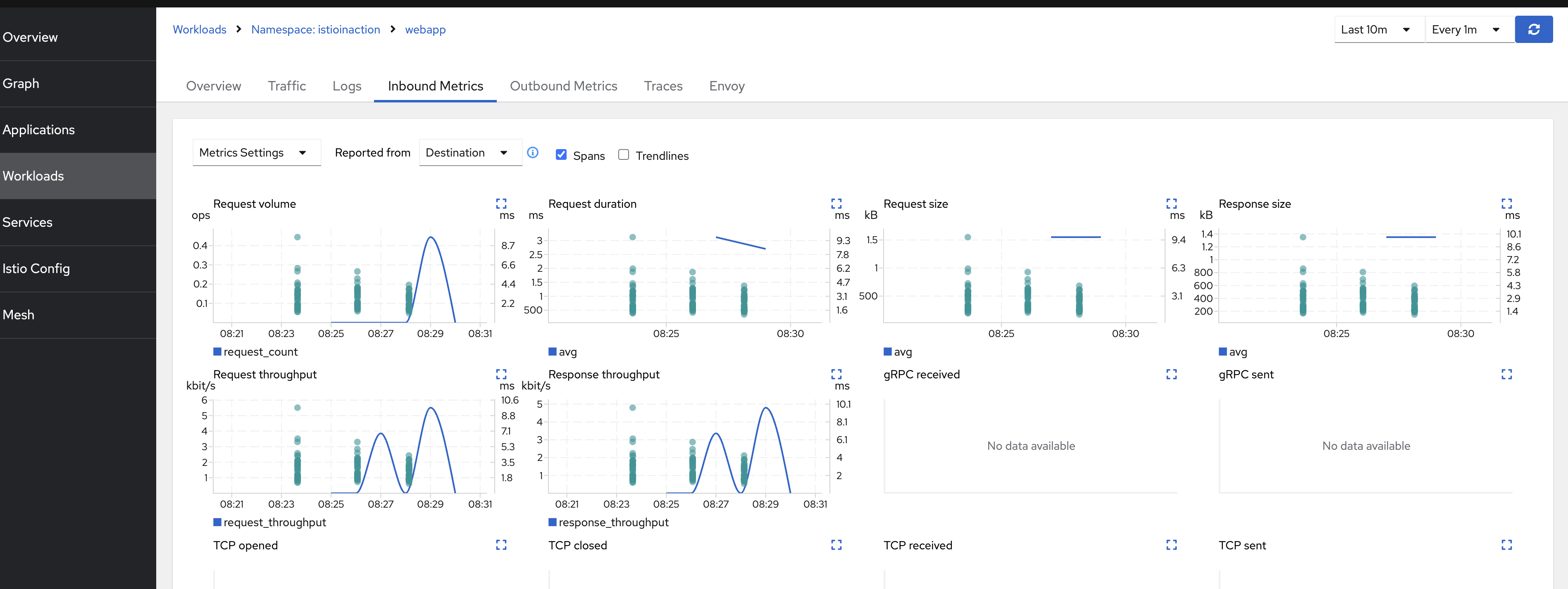

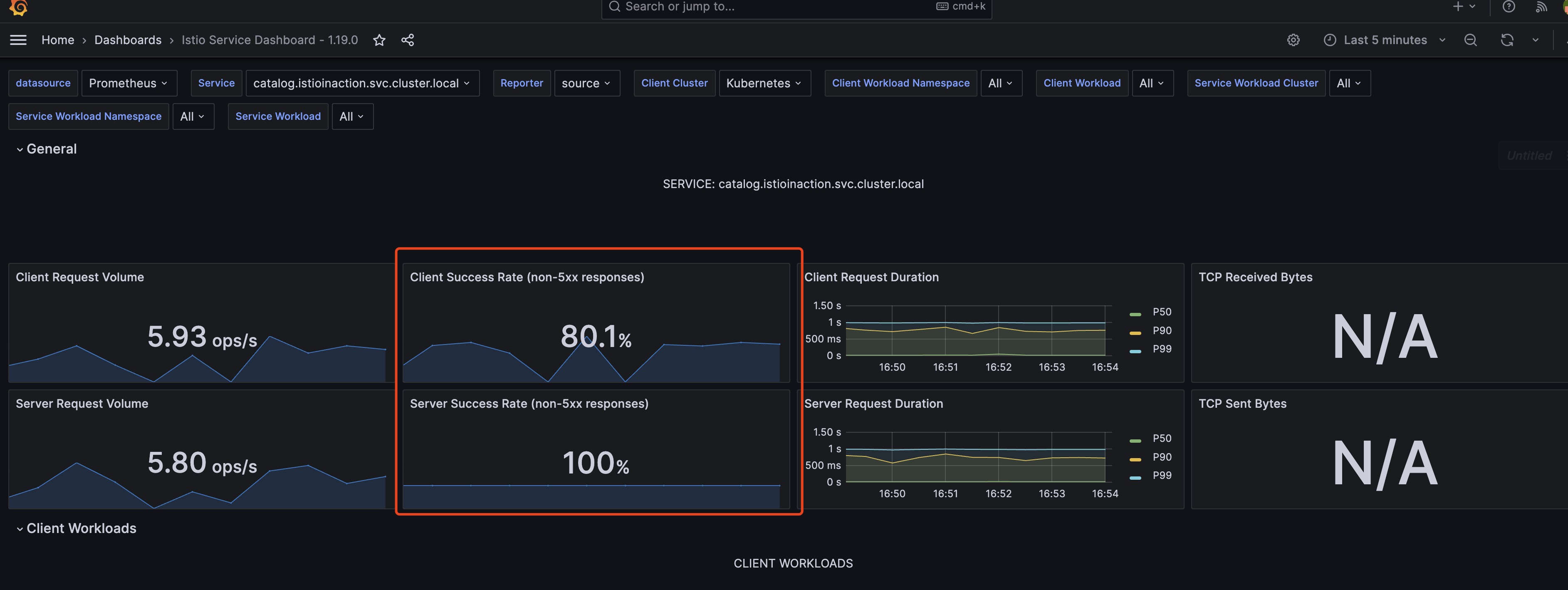

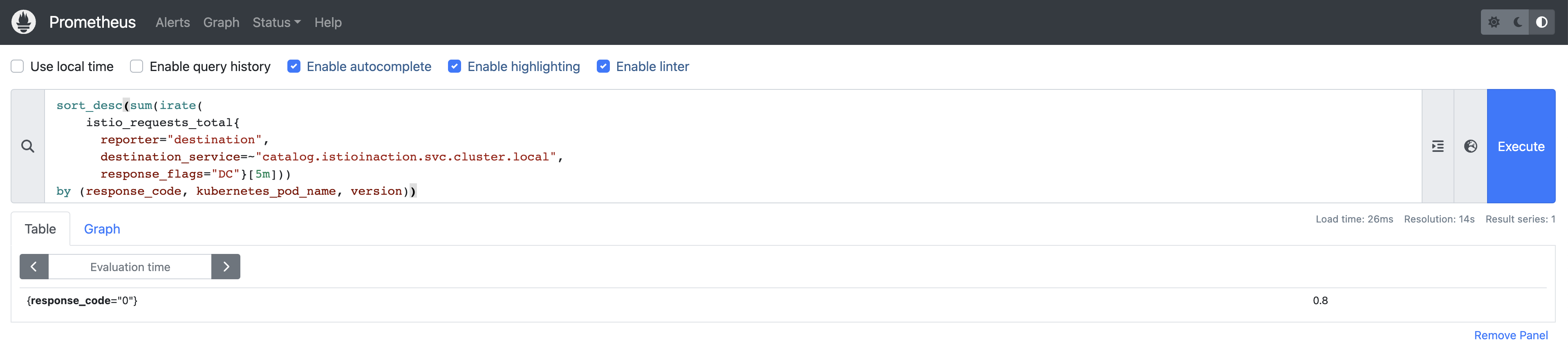

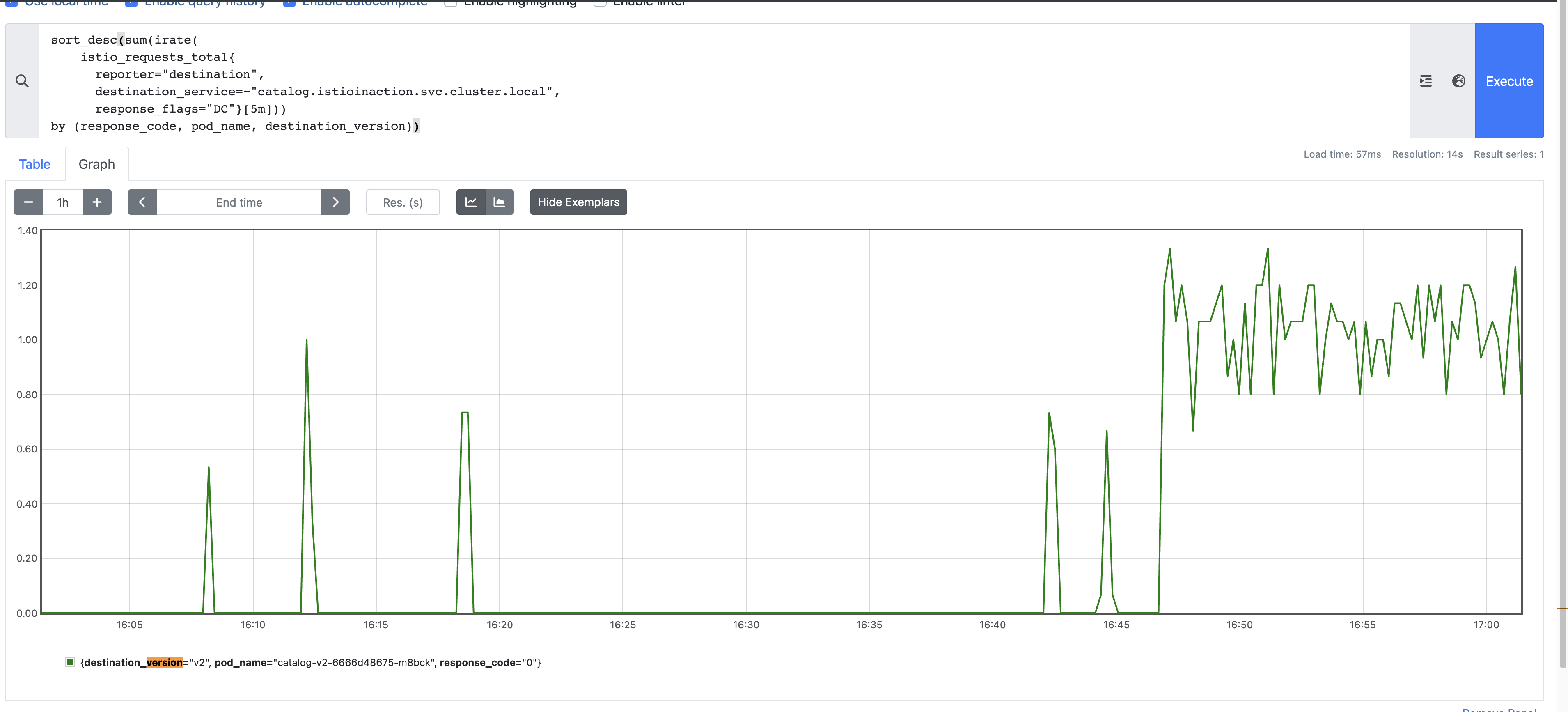

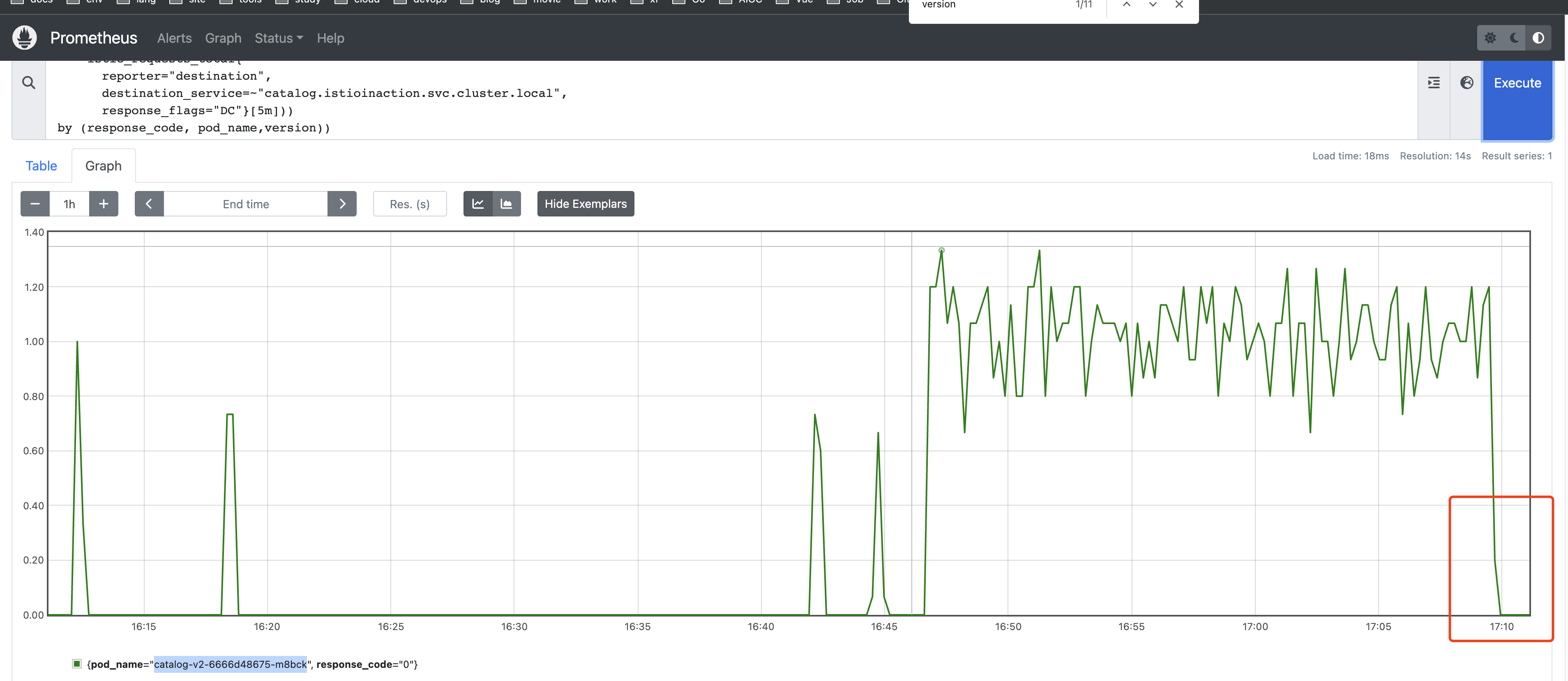

可观察性#

可观察性是系统的一种特性,它是通过观察系统的外部信号和特征来了解和推理系统内部状态的程度来衡量的。

文档

了解服务状态#

- Metrics 说明: https://istio.io/latest/docs/reference/config/metrics/

istio_requests_total: 从入口网关向服务发出的请求的指标istio_request_bytesistio_response_bytesistio_request_durationistio_request_duration_milliseconds

- Envoy 在识别流量时有一个内部来源和外部来源的概念。内部流量通常指来自网状网内部的流量,外部流量指来自网状网外部的流量(进入入口网关的流量)。

- 通过

cluster_name.internal.*指标,我们可以查看有多少成功请求来自内部或网状网络内部: cluster_name.ssl.*指标 , 确定流量是否通过 TLS 进入上游群集,以及与连接相关的任何其他细节(密码、曲线等等)

- 通过

- 各 Envoy cluster 指标说明: https://www.envoyproxy.io/docs/envoy/latest/configuration/upstream/cluster_manager/cluster_stats#general

cd /Users/yangzun/Desktop/istio-1.19.0

kubectl delete -f samples/addons/

# 清理

kubectl config set-context $(kubectl config current-context) \

--namespace=istioinaction

kubectl delete virtualservice,deployment,service,\

destinationrule,gateway --all

# 部署应用

kubectl apply -f services/catalog/kubernetes/catalog.yaml

kubectl apply -f services/webapp/kubernetes/webapp.yaml

kubectl apply -f services/webapp/istio/webapp-catalog-gw-vs.yaml

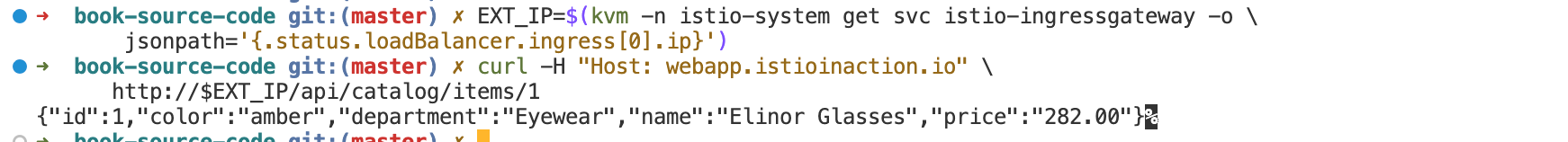

# 测试

curl -H "Host: webapp.istioinaction.io" http://192.168.8.212/api/catalog

# 查看 webapp 的统计数据

kubectl exec -it deploy/webapp -c istio-proxy \

-- curl localhost:15000/stats

# 使用 pilot-agent 查看,help: pilot-agent request GET help

kubectl exec -it deploy/webapp -c istio-proxy \

-- pilot-agent request GET stats

# 配置代理以报告更多特使统计数据

spec:

profile: demo

meshConfig:

defaultConfig: ❶ 为所有服务定义默认代理配置

proxyStatsMatcher: ❷ 自定义报告的指标

inclusionPrefixes: ❸ 与前缀匹配的指标将与默认指标一起报告。

- "cluster.outbound|80||catalog.istioinaction"

# 在整个网格中增加收集的度量指标可能会使度量指标收集系统超负荷,因此应该非常谨慎。更好的方法是以注释的形式按工作量指定所包含的指标。

metadata:

annotations:

proxy.istio.io/config: |- ❶

proxyStatsMatcher:

inclusionPrefixes:

- "cluster.outbound|80||catalog.istioinaction"

kubectl apply -f ch7/webapp-deployment-stats-inclusion.yaml

curl -H "Host: webapp.istioinaction.io" http://192.168.8.212/api/catalog

kubectl exec -it deploy/webapp -c istio-proxy \

-- curl localhost:15000/stats | grep catalog

...

cluster.outbound|80||catalog.istioinaction.svc.cluster.local.bind_errors: 0

cluster.outbound|80||catalog.istioinaction.svc.cluster.local.circuit_breakers.default.cx_open: 0

cluster.outbound|80||catalog.istioinaction.svc.cluster.local.circuit_breakers.default.cx_pool_open: 0

...

# 查询,列出代理知道的所有后端群集及其各自端点的信息

# 该查询能够输出,端点位于哪个区域、区域和子区域;以及该上游端点的任何活动请求或错误。上一组统计数据提供的是整个集群的数据。通过这组统计信息,我们可以看到每个端点的详细信息。

# https://www.envoyproxy.io/docs/envoy/latest/configuration/upstream/cluster_manager/cluster_stats#general

kubectl exec -it deploy/webapp -c istio-proxy \

-- curl localhost:15000/clusters|grep catalog

控制平面中的指标#

https://istio.io/latest/docs/reference/commands/pilot-discovery/#metrics

# 要查看控制平面指标

kubectl exec -it -n istio-system deploy/istiod -- curl localhost:15014/metrics

使用 Prometheus 抓取 Istio 指标#

# 查看 公开的 Prometheus

kubectl exec -it deploy/webapp -c istio-proxy \

-- curl localhost:15090/stats/prometheus

a安装 Prometheus 和 Grafana

cd ~/Desktop/istio-1.19.0

kubectl delete -f samples/addons/

# 使用 helm 安装 prometheus

helm repo add prometheus-community \

https://prometheus-community.github.io/helm-charts

helm repo update

kubectl create ns prometheus

helm pull prometheus-community/kube-prometheus-stack --untar

helm install prom ./kube-prometheus-stack \

-n prometheus -f kube-prometheus-stack/values-prod.yaml

创建 ServiceMonitor 监控 istio

apiVersion: monitoring.coreos.com/v1

kind: ServiceMonitor

metadata:

name: istio-component-monitor

namespace: prometheus

labels:

monitoring: istio-components

release: prom

spec:

jobLabel: istio

targetLabels: [app]

selector:

matchExpressions:

- {key: istio, operator: In, values: [pilot]}

namespaceSelector:

any: true

endpoints:

- port: http-monitoring

interval: 15s

---

kubectl apply -f ch7/service-monitor-cp.yaml

kubectl -n prometheus port-forward \

statefulset/prometheus-prom-kube-prometheus-stack-prometheus 9090

配置 PodMonitor 资源,抓取包含 istio-proxy 容器的每个 Pod 的指标

apiVersion: monitoring.coreos.com/v1

kind: PodMonitor

metadata:

name: envoy-stats-monitor

namespace: prometheus

labels:

monitoring: istio-proxies

release: prom

spec:

selector:

matchExpressions:

- {key: istio-prometheus-ignore, operator: DoesNotExist}

namespaceSelector:

any: true

jobLabel: envoy-stats

podMetricsEndpoints:

- path: /stats/prometheus

interval: 15s

relabelings:

- action: keep

sourceLabels: [__meta_kubernetes_pod_container_name]

regex: "istio-proxy"

- action: keep

sourceLabels: [__meta_kubernetes_pod_annotationpresent_prometheus_io_scrape]

- sourceLabels: [__address__, __meta_kubernetes_pod_annotation_prometheus_io_port]

action: replace

regex: ([^:]+)(?::\d+)?;(\d+)

replacement: $1:$2

targetLabel: __address__

- action: labeldrop

regex: "__meta_kubernetes_pod_label_(.+)"

- sourceLabels: [__meta_kubernetes_namespace]

action: replace

targetLabel: namespace

- sourceLabels: [__meta_kubernetes_pod_name]

action: replace

targetLabel: pod_name

---

kubectl apply -f ch7/pod-monitor-dp.yaml

# 为数据平面生成一些负载

for i in {1..100}; do curl http://192.168.8.212/api/catalog -H \

"Host: webapp.istioinaction.io"; sleep .5s; done

标准指标

| istio_requests_total | 每个请求都会递增的 COUNTER |

|---|---|

| istio_request_duration_milliseconds | 每次请求通过时递增的计数器 |

| istio_request_bytes | 测量请求体大小的分布 |

| istio_response_bytes | 测量响应主体大小的分布 |

| istio_request_messages_total | (gRPC) 对于来自客户端的报文,计数器递增 |

| istio_response_messages_total | (gRPC) 从服务器发送的信息的 COUNTER 递增 |

Envoy 请求属性#

| 属性 | 说明 |

|---|---|

| request.path | URL 的路径部分 |

| request.url_path | 不含查询字符串的 URL 路径部分 |

| request.host | URL 的主机部分 |

| request.scheme | URL 的方案部分(如 “http) |

| request.method | 请求方法(如 “GET) |

| request.headers | 以小写标头名称为索引的所有请求标头 |

| request.referer | 请求标头 |

| request.useragent | 用户代理请求标头 |

| request.time | 收到第一个字节的时间 |

| request.id | 与x-request-id头部值对应的请求ID |

| request.protocol | 请求协议 |

其他属性

- Response

- Connection

- Upstream

- Metadata/filter state

- Wasm

配置现有指标#

# 查看已安装的 envoyfilter

kubectl get envoyfilter -n istio-system

value:

name: istio.stats ❶ 过滤器名称

typed_config:

'@type': type.googleapis.com/udpa.type.v1.TypedStruct

type_url: type.googleapis.com/

envoy.extensions.filters.http.wasm.v3.Wasm

value:

config: ❷ 过滤器配置

configuration:

为现有指标增加维度

# 添加 upstream_proxy_version 和 source_mesh_id 维度

profile: demo

values:

telemetry:

v2:

prometheus:

configOverride:

inboundSidecar:

metrics:

- name: requests_total

dimensions: ❶ 新增维度

upstream_proxy_version: upstream_peer.istio_version

source_mesh_id: node.metadata['MESH_ID']

tags_to_remove: ❷ 要删除的标记列表

- request_protocol

outboundSidecar:

istioctl install -f ch7/metrics/istio-operator-new-dimensions.yaml -y

# 让 Istio 的代理知道它。为此,我们必须使用 sidecar.istio.io/extraStatTags 注解注释部署 Pod 规范。

# 注意,该注解需要放在 spec.template.metadata Pod 模板上,而不是部署元数据本身

spec:

replicas: 1

selector:

matchLabels:

app: webapp

template:

metadata:

annotations:

proxy.istio.io/config: |-

extraStatTags:

- "upstream_proxy_version"

- "source_mesh_id"

labels:

app: webapp

kubectl -n istioinaction apply -f \

ch7/metrics/webapp-deployment-extrastats.yaml

curl -H "Host: webapp.istioinaction.io" \

http://192.168.8.212/api/catalog

kubectl -n istioinaction exec -it deploy/webapp -c istio-proxy \

-- curl localhost:15000/stats/prometheus | grep istio_requests_total

# 您应该会看到类似下面的内容(您可能会看到两个条目:一个是入站流量,一个是出站流量):

istio_requests_total{

...

source_mesh_id="cluster.local",

upstream_proxy_version="1.19.0"} 1

# 另外请注意, request_protocol 维度不在维度列表中,因为我们在之前的配置中删除了它

Istio 在 Istio 1.12 中引入了新的 Telemetry API,为用户配置度量指标提供了更多灵活性和控制。在本节中,我们使用 IstioOperator 来安装新的度量配置,但这种方法会对度量进行全局配置。如果我们想将指标配置限制在 单个命名空间或单个工作负载,可以使用新的遥测 API。

https://istio.io/latest/docs/reference/config/telemetry/#Telemetry

# 等效上面操作的示例

apiVersion: telemetry.istio.io/v1alpha1

kind: Telemetry

metadata:

name: add-dimension-tags

namespace: istioinaction

spec:

metrics:

- providers:

- name: prometheus

overrides:

- match:

metric: REQUEST_COUNT

mode: CLIENT_AND_SERVER

disabled: false

tagOverrides:

upstream_proxy_version:

operation: UPSERT

value: upstream_peer.istio_version

source_mesh_id:

operation: UPSERT

value: node.metadata['MESH_ID']

request_protocol:

operation: REMOVE

kubectl apply -f ch7/metrics/v2/add-dimensions-telemetry.yaml

创建新指标#

创建一个名为istio_get_calls的新指标,但请注意我们将其定义为get_calls。如前所述,istio_前缀会自动添加。我们将此指标定义为COUNTER,但也可以选择GAUGE和HISTOGRAM。该指标的值是一个字符串,它是一个通用表达式语言(CEL;https://opensource.google/projects/cel)表达式,必须返回整数以满足COUNTER类型要求。这个CEL表达式操作属性,在这种情况下,我们计算的是HTTP GET请求的数量。

新版本中,可以使用

Telemetry(Alpha) 资源来控制指标生成,具体文档 :

# 示例, 为 stats 插件配置新的度量定义

apiVersion: install.istio.io/v1alpha1

kind: IstioOperator

spec:

profile: demo

values:

telemetry:

v2:

prometheus:

configOverride:

inboundSidecar:

definitions:

- name: get_calls

type: COUNTER

value: "(request.method.startsWith('GET') ? 1 : 0)"

outboundSidecar:

definitions:

- name: get_calls

type: COUNTER

value: "(request.method.startsWith('GET') ? 1 : 0)"

gateway:

definitions:

- name: get_calls

type: COUNTER

value: "(request.method.startsWith('GET') ? 1 : 0)"

istioctl install -f ch7/metrics/istio-operator-new-metric.yaml -y

# pod 添加注解,在代理上公开这些 metrics

spec:

replicas: 1

selector:

matchLabels:

app: webapp

template:

metadata:

annotations:

proxy.istio.io/config: |-

proxyStatsMatcher:

inclusionPrefixes:

- "istio_get_calls"

labels:

app: webapp

kubectl -n istioinaction apply -f \

ch7/metrics/webapp-deployment-new-metric.yaml

curl -H "Host: webapp.istioinaction.io" \

http://192.168.8.212/api/catalog

kubectl -n istioinaction exec -it deploy/webapp -c istio-proxy \

-- curl localhost:15000/stats/prometheus | grep istio_get_calls

# TYPE istio_get_calls counter

istio_get_calls{} 2

使用新属性对请求进行分组#

可以基于现有属性创建新的属性,使其更细粒度或领域特定。例如,我们可以创建一个名为istio_operationId的新属性,它将request.path_url和request.method结合起来,以尝试跟踪目录服务上/items API的GET调用次数。为此,我们使用Istio attribute-gen代理插件,这是另一个用于自定义代理指标行为的Wasm扩展。attribute-gen插件与前面一节中使用过的stats插件相辅相成。attribute-gen插件在stats插件之前进行层叠操作,以便任何它创建的属性都可以在统计数据中使用。

参考文档:

- https://istio.io/latest/docs/reference/config/networking/envoy-filter/

- https://istio.io/latest/docs/reference/config/networking/envoy-filter/

- https://istio.io/latest/zh/docs/tasks/observability/metrics/classify-metrics/

# 使用 EnvoyFilter 资源配置 attribute-gen 插件

{

"attributes": [

{

"output_attribute": "istio_operationId", ❶ 属性名称

"match": [

{

"value": "getitems", ❷ 属性值

"condition": "request.url_path == '/items'

&& request.method == 'GET'"

},

}

kubectl apply -f ch7/metrics/attribute-gen.yaml

# 创建一个名为 upstream_operation 的新维度,该维度使用 istio_requests_total 指标中的属性来识别对 catalog 的 API 调用。

istioctl install -y -f ch7/metrics/istio-operator-new-attribute.yaml

# 使用新维度时,我们还需要将其添加到服务中的 extraStats 注解中

kubectl apply -f ch7/metrics/webapp-deployment-extrastats-new-attr.yaml

curl -H "Host: webapp.istioinaction.io" \

http://192.168.8.212/api/catalog

curl -H "Host: webapp.istioinaction.io" \

http://192.168.8.212/items

kubectl -n istioinaction exec -it deploy/webapp -c istio-proxy \

-- curl localhost:15000/stats/prometheus | grep istio_requests_total

kubectl exec -it deploy/webapp -c istio-proxy \

-- curl -X POST localhost:15000/reset_counters # 清理指标

Google SRE 一书[ https://sre.google/sre-book/monitoring-distributed-systems] 将以下指标称为黄金信号指标:

延迟

吞吐量

错误和饱和度

新版本中貌似一被 WasmPlugin 替代

https://istio.io/latest/zh/docs/tasks/observability/metrics/classify-metrics/

使用此种方法时,需要在 VirtualService 中指定注入

# 清理环境

kubectl config set-context $(kubectl config current-context) \

--namespace=istioinaction

kubectl delete virtualservice,deployment,service,\

destinationrule,gateway,WasmPlugin,Telemetry --all

# 创建应用

kubectl apply -f services/catalog/kubernetes/catalog.yaml

kubectl apply -f services/webapp/kubernetes/webapp.yaml

kubectl apply -f services/webapp/istio/webapp-catalog-gw-vs.yaml

# 测试

curl -H "Host: webapp.istioinaction.io" \

http://192.168.8.212/api/catalog

---

kubectl apply -f << EOF -

apiVersion: extensions.istio.io/v1alpha1

kind: WasmPlugin

metadata:

name: istio-attributegen-filter

namespace: istioinaction

spec:

selector:

matchLabels:

app: webapp

url: https://storage.googleapis.com/istio-build/proxy/attributegen-359dcd3a19f109c50e97517fe6b1e2676e870c4d.wasm

imagePullPolicy: Always

phase: AUTHN

pluginConfig:

attributes:

- output_attribute: "istio_operationId"

match:

- value: "ListCatalog"

condition: "request.url_path == '/api/catalog' && request.method == 'GET'"

---

apiVersion: telemetry.istio.io/v1alpha1

kind: Telemetry

metadata:

name: custom-tags

namespace: istioinaction

spec:

metrics:

- overrides:

- match:

metric: REQUEST_COUNT

mode: CLIENT_AND_SERVER

tagOverrides:

request_operation:

value: istio_operationId

providers:

- name: prometheus

EOF

# istioctl install -y -f ch7/metrics/istio-operator-new-attribute.yaml

---

for i in $(seq 1 5);do

curl -H "Host: webapp.istioinaction.io" http://192.168.8.212/api/catalog && echo -e "\n"

done

while true;do

curl -H "Host: webapp.istioinaction.io" http://192.168.8.212/api/catalog && echo -e "\n" && sleep 1

done

kubectl -n istioinaction exec -it deploy/webapp -c istio-proxy \

-- curl localhost:15000/stats/prometheus | grep istio_requests_total

# DEBUG

kubectl logs deploy/webapp -c istio-proxy | grep -e "Config Error" -e "envoy wasm"

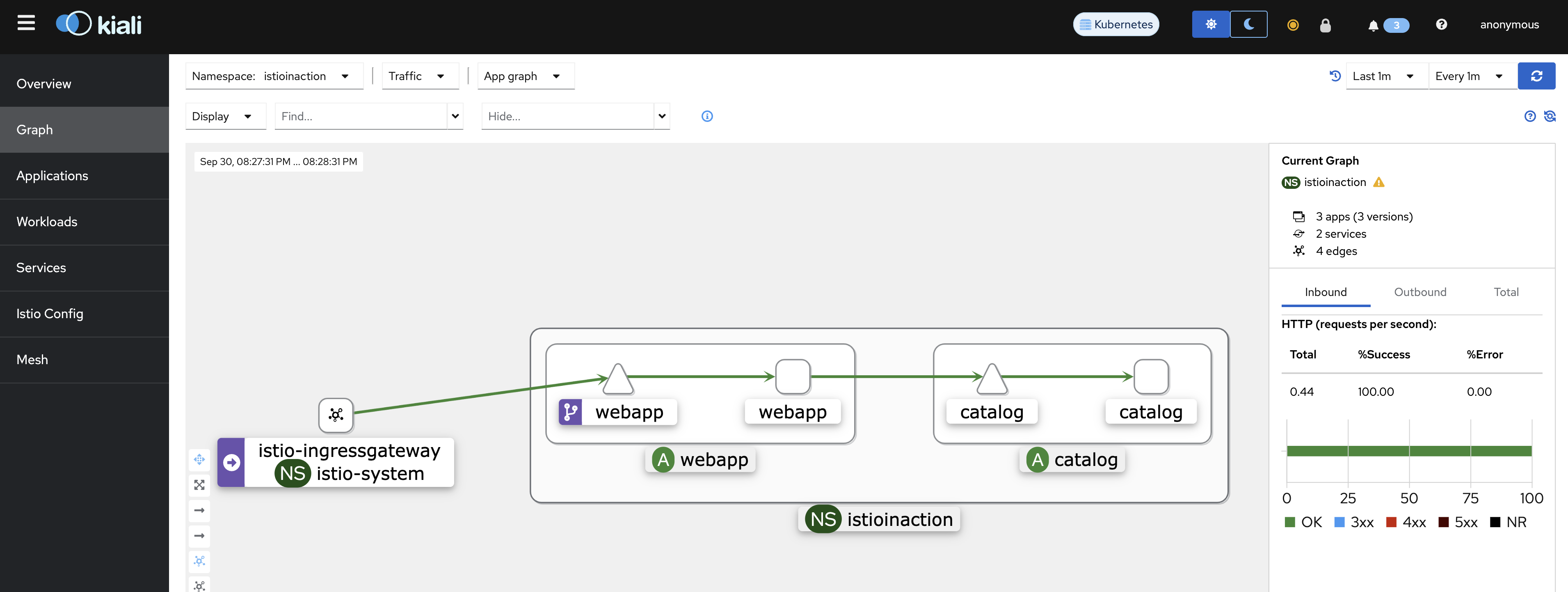

可视化#

打开 Grafana

# 代理 Grafana , U/P: admin prom-operator

kubectl -n prometheus port-forward svc/prom-grafana 3000:80

设置 Istio 的 Grafana 仪表板#

cd ch8/

kubectl -n prometheus create cm istio-dashboards \

--from-file=pilot-dashboard.json=dashboards/pilot-dashboard.json \

--from-file=istio-workload-dashboard.json=dashboards/\

istio-workload-dashboard.json \

--from-file=istio-service-dashboard.json=dashboards/\

istio-service-dashboard.json \

--from-file=istio-performance-dashboard.json=dashboards/\

istio-performance-dashboard.json \

--from-file=istio-mesh-dashboard.json=dashboards/\

istio-mesh-dashboard.json \

--from-file=istio-extension-dashboard.json=dashboards/\

istio-extension-dashboard.json

# 将 cm 注入成 grafana_dashboard

kubectl label -n prometheus cm istio-dashboards grafana_dashboard=1

分布式追踪#

OpenTelemetry是一个由社区驱动的框架,其中包括了OpenTracing,它是一种规范,用于捕获与分布式跟踪相关的概念和API。分布式跟踪在某种程度上依赖于开发人员对其代码进行仪器化,并在应用程序处理请求并向其他系统发出新请求时进行注释。追踪引擎有助于组合请求流程的完整图像,可以用来识别我们架构中行为异常的区域。

借助 Istio,我们可以承担开发人员必须自己实现的大部分繁重工作,并提供分布式跟踪作为服务网格的一部分。

一个 Span 是表示服务或组件内的工作单元的数据集合。这些数据包括操作的开始时间、结束时间、操作名称以及一组标签和日志。

OpenTracing 实现包括如下系统:

- Jaeger

- Zipkin

- Lightstep

- Instana

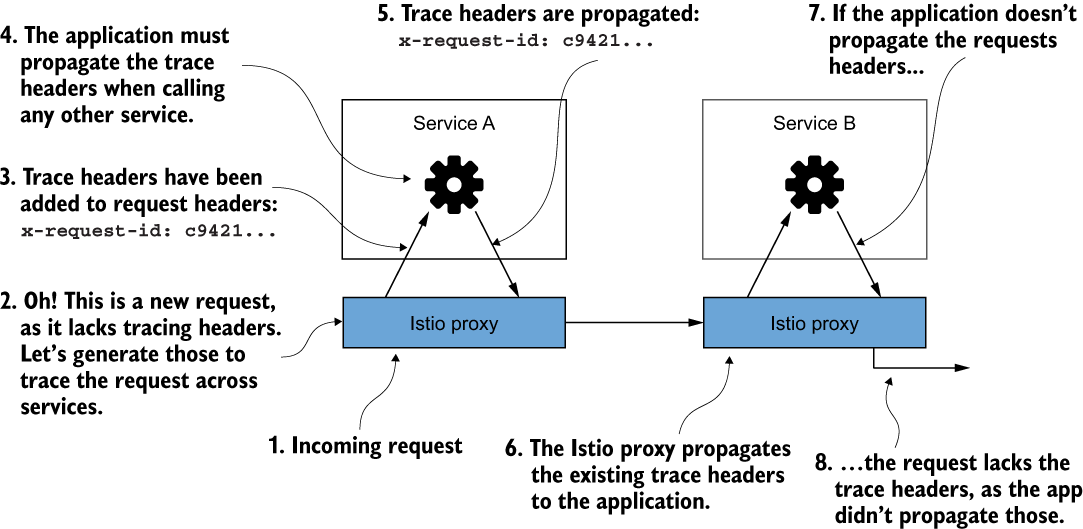

Istio 将 HTTP 标头(通常称为 Zipkin 跟踪标头)附加到请求中,可用于将后续 Span 对象与整个 Trace 相关联。如果请求进入服务并且 Istio 代理识别分布式跟踪标头,代理会将其视为正在进行的跟踪,并且不会尝试生成新的跟踪。 Istio 和分布式跟踪功能使用以下 Zipkin 跟踪标头:

x-request-idx-b3-traceidx-b3-spanidx-b3-parentspanidx-b3-sampledx-b3-flagsx-ot-span-context

Istio 无法知道哪些传出调用是哪些传入请求的结果。为了正确地将上游调用与进入服务的调用相关联,应用程序必须承担传播这些标头的责任。很多时候,开箱即用的 RPC 框架与 OpenTracing 集成或直接支持 OpenTracing,并且可以自动为您传播这些标头。无论哪种方式,应用程序都必须确保传播这些标头。

应用程序必须传播跟踪标头。否则,我们将丢失请求的完整范围。

安装分布式跟踪系统

Jaeger: Jaeger

# 从 Istio 示例目录安装示例 Jaeger 一体化部署

cd ~/Desktop/istio-1.19.0

kubectl apply -f samples/addons/jaeger.yaml

# 等待服务启动完成

kubectl get pod -n istio-system

kubectl get svc -n istio-system

可以配置 Istio 进行多个级别的分布式跟踪:全局网格、命名空间或特定工作负载。

在安装时配置跟踪

# Istio 支持分布式跟踪后端,包括 Zipkin、Datadog、Jaeger(Zipkin 兼容)等。

apiVersion: install.istio.io/v1alpha1

kind: IstioOperator

metadata:

namespace: istio-system

spec:

meshConfig:

defaultConfig:

tracing:

lightstep: {}

zipkin: {}

datadog: {}

stackdriver: {}

---

# 使用 Jaeger,它与 Zipkin 兼容,我们可以配置如下

apiVersion: install.istio.io/v1alpha1

kind: IstioOperator

metadata:

namespace: istio-system

spec:

meshConfig:

defaultConfig:

tracing:

sampling: 100

zipkin:

address: zipkin.istio-system:9411

istioctl install -y -f ch8/install-istio-tracing-zipkin.yaml

# 已经安装了 Istio 并且没有配置跟踪后端,或者想要更新配置,您可以在 istioconfigmap 中的 MeshConfig 对象中看到 Istio 的网格范围默认值在 istio-system 命名空间中

kubectl get cm istio -n istio-system -o yaml

...

data:

mesh: |-

defaultConfig:

discoveryAddress: istiod.istio-system.svc:15012

proxyMetadata: {}

tracing:

sampling: 100

zipkin:

address: zipkin.istio-system:9411

defaultProviders:

metrics:

- prometheus

...

# 配置工作负载的 TRACING, 下面是 Deployment 的例子

apiVersion: apps/v1

kind: Deployment

...

spec:

template:

metadata:

annotations:

proxy.istio.io/config: |

tracing:

zipkin:

address: zipkin.istio-system:9411

# 检查默认 TRACING 标头

# 使用 Istio 的入口网关调用外部 httpbin 服务并调用显示请求标头的端点。

kubectl apply -n istioinaction \

-f ch8/tracing/thin-httpbin-virtualservice.yaml

curl -H "Host: httpbin.istioinaction.io" http://192.168.8.212/headers

{

"headers": {

"Accept": "*/*",

"Host": "httpbin.istioinaction.io",

"User-Agent": "curl/8.1.2",

"X-Amzn-Trace-Id": "Root=1-65180064-39d6410b0b3e94550ef3b250",

"X-B3-Sampled": "1",

"X-B3-Spanid": "34914a388f45a982",

"X-B3-Traceid": "a8440b2adfa0236034914a388f45a982",

"X-Envoy-Attempt-Count": "1",

"X-Envoy-Decorator-Operation": "httpbin.org:80/*",

"X-Envoy-Internal": "true",

"X-Envoy-Peer-Metadata": "ChoKCkNMVVNURVJfSUQSDBoKS3ViZXJuZXRlcwodCgxJTlNUQU5DRV9JUFMSDRoLMTAuNDIuNC4xMTEKGQoNSVNUSU9fVkVSU0lPThIIGgYxLjE5LjAKnAMKBkxBQkVMUxKRAyqOAwodCgNhcHASFhoUaXN0aW8taW5ncmVzc2dhdGV3YXkKEwoFY2hhcnQSChoIZ2F0ZXdheXMKFAoIaGVyaXRhZ2USCBoGVGlsbGVyCjYKKWluc3RhbGwub3BlcmF0b3IuaXN0aW8uaW8vb3duaW5nLXJlc291cmNlEgkaB3Vua25vd24KGQoFaXN0aW8SEBoOaW5ncmVzc2dhdGV3YXkKGQoMaXN0aW8uaW8vcmV2EgkaB2RlZmF1bHQKMAobb3BlcmF0b3IuaXN0aW8uaW8vY29tcG9uZW50EhEaD0luZ3Jlc3NHYXRld2F5cwoSCgdyZWxlYXNlEgcaBWlzdGlvCjkKH3NlcnZpY2UuaXN0aW8uaW8vY2Fub25pY2FsLW5hbWUSFhoUaXN0aW8taW5ncmVzc2dhdGV3YXkKLwojc2VydmljZS5pc3Rpby5pby9jYW5vbmljYWwtcmV2aXNpb24SCBoGbGF0ZXN0CiIKF3NpZGVjYXIuaXN0aW8uaW8vaW5qZWN0EgcaBWZhbHNlChoKB01FU0hfSUQSDxoNY2x1c3Rlci5sb2NhbAovCgROQU1FEicaJWlzdGlvLWluZ3Jlc3NnYXRld2F5LTU5Yzc4Njc2OGQtY2duNTUKGwoJTkFNRVNQQUNFEg4aDGlzdGlvLXN5c3RlbQpdCgVPV05FUhJUGlJrdWJlcm5ldGVzOi8vYXBpcy9hcHBzL3YxL25hbWVzcGFjZXMvaXN0aW8tc3lzdGVtL2RlcGxveW1lbnRzL2lzdGlvLWluZ3Jlc3NnYXRld2F5CicKDVdPUktMT0FEX05BTUUSFhoUaXN0aW8taW5ncmVzc2dhdGV3YXk=",

"X-Envoy-Peer-Metadata-Id": "router~10.42.4.111~istio-ingressgateway-59c786768d-cgn55.istio-system~istio-system.svc.cluster.local"

}

}

# 可以清楚地看到 x-b3-* Zipkin 标头自动附加到我们的请求中。这些 Zipkin 标头用于创建 Span 并发送给 Jaeger

查看分布式跟踪数据#

istioctl dashboard jaeger --browser=false

调整网格的跟踪采样

# 将服务网格中所有工作负载的全局采样率更改为 10%。

kubectl edit -n istio-system cm istio

apiVersion: v1

data:

mesh: |-

accessLogFile: /dev/stdout

defaultConfig:

discoveryAddress: istiod.istio-system.svc:15012

proxyMetadata: {}

tracing:

sampling: 10

zipkin:

address: zipkin.istio-system:9411

# 除了全局配置之外,我们还可以在注释中针对每个工作负载进行配置。

apiVersion: apps/v1

kind: Deployment

...

spec:

template:

metadata:

annotations:

proxy.istio.io/config: |

tracing:

sampling: 10

zipkin:

address: zipkin.istio-system:9411

kubectl apply -f ch8/webapp-deployment-zipkin.yaml

来自客户端的强制追踪

在生产中,将跟踪采样率保持在 最低水平 然后在出现问题时针对每个工作负载启用它非常有意义。有时您需要启用特定跟踪的跟踪。您可以配置 Istio 以强制跟踪特定请求。

# 将 x-envoy-force-trace 标头添加到请求中,以触发 Istio 捕获请求生成的特定调用图的跨度和跟踪。

curl -H "x-envoy-force-trace: true" \

-H "Host: webapp.istioinaction.io" http://192.168.8.212/api/catalog

每次我们发送此 x-envoy-force-trace 标头时,我们都会触发对该请求以及该请求的整个调用图的跟踪

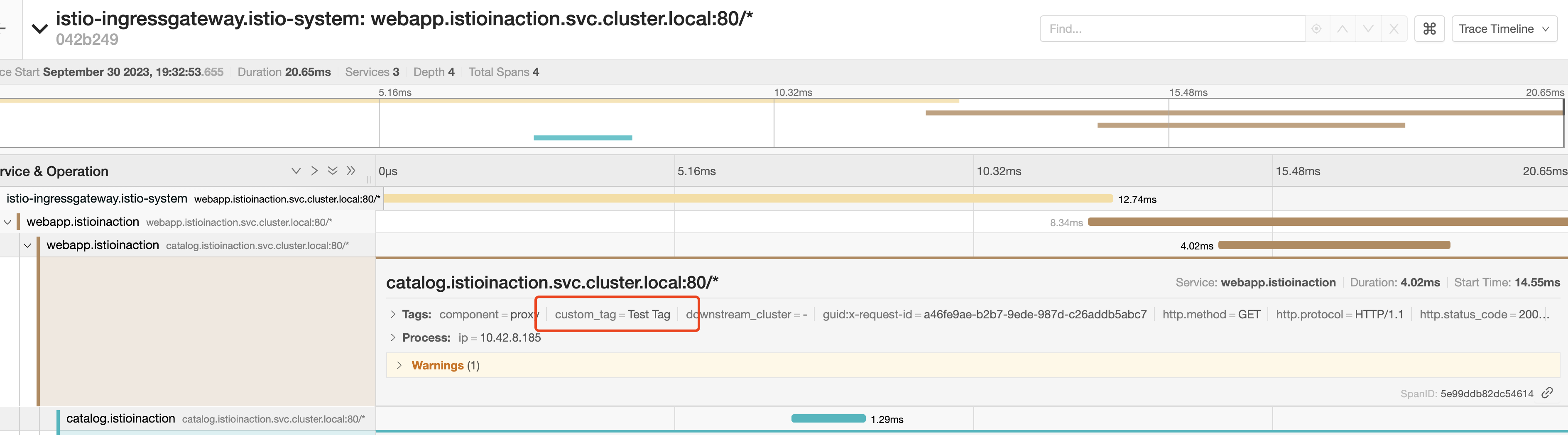

自定义跟踪中的标签#

可以配置三种不同类型的自定义标签

- 显式指定一个值

- 从环境变量中提取值

- 从请求标头中提取值

** 注释该工作负载的 Deployment 资源**

apiVersion: apps/v1

kind: Deployment

...

spec:

template:

metadata:

annotations:

proxy.istio.io/config: |

tracing:

sampling: 100

customTags:

custom_tag:

literal:

value: "Test Tag"

zipkin:

address: zipkin.istio-system:9411

curl -H "Host: webapp.istioinaction.io" \

http://192.168.8.212/api/catalog

自定义标签可用于报告、过滤和以其他方式探索跟踪数据

定制后端分布式追踪引擎#

# 查看 默认跟踪配置

istioctl pc bootstrap -n istioinaction deploy/webapp \

-o json | jq .bootstrap.tracing

{

"http": {

"name": "envoy.tracers.zipkin",

"typedConfig": {

"@type": "type.googleapis.com/envoy.config.trace.v3.ZipkinConfig",

"collectorCluster": "zipkin",

"collectorEndpoint": "/api/v2/spans",

"traceId128bit": true,

"sharedSpanContext": false,

"collectorEndpointVersion": "HTTP_JSON"

}

}

}

# 跟踪引擎配置为基于Zipkin,发送到/api/v2/spans端点,并将其视为JSON端点。如果我们需要覆盖这些设置或以任何方式进行调整,则必须能够在使用Zipkin作为跟踪引擎时覆盖Istio中内置的静态定义。我们可以通过自定义启动配置来实现这一点。

# 在 Kubernetes configmap 中指定要调整的配置片段

apiVersion: v1

kind: ConfigMap

metadata:

name: istio-custom-zipkin

data:

custom_bootstrap.json: |

{

"tracing": {

"http": {

"name": "envoy.tracers.zipkin",

"typedConfig": {

"@type": "type.googleapis.com/

envoy.config.trace.v3.ZipkinConfig",

"collectorCluster": "zipkin",

"collectorEndpoint": "/zipkin/api/v1/spans",

"traceId128bit": "true",

"collectorEndpointVersion": "HTTP_JSON"

}

}

}

}

kubectl apply -f ch8/istio-custom-bootstrap.yaml \

-n istioinaction

# 在 Deployment 资源的 Pod 模板中添加一个注解来引用这个 configmap

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: webapp

name: webapp

spec:

replicas: 1

selector:

matchLabels:

app: webapp

template:

metadata:

annotations:

sidecar.istio.io/bootstrapOverride: "istio-custom-zipkin"

kubectl apply -f ch8/webapp-deployment-custom-boot.yaml \

-n istioinaction

# 自定义引导配置与幕后使用的 Envoy 代理版本相关,并且不能保证向后兼容性。任何错误配置都可能导致的服务瘫痪。

istioctl pc bootstrap -n istioinaction deploy/webapp \

-o json | jq .bootstrap.tracing

{

"http": {

"name": "envoy.tracers.zipkin",

"typedConfig": {

"@type": "type.googleapis.com/envoy.config.trace.v3.ZipkinConfig",

"collectorCluster": "zipkin",

"collectorEndpoint": "/zipkin/api/v1/spans",

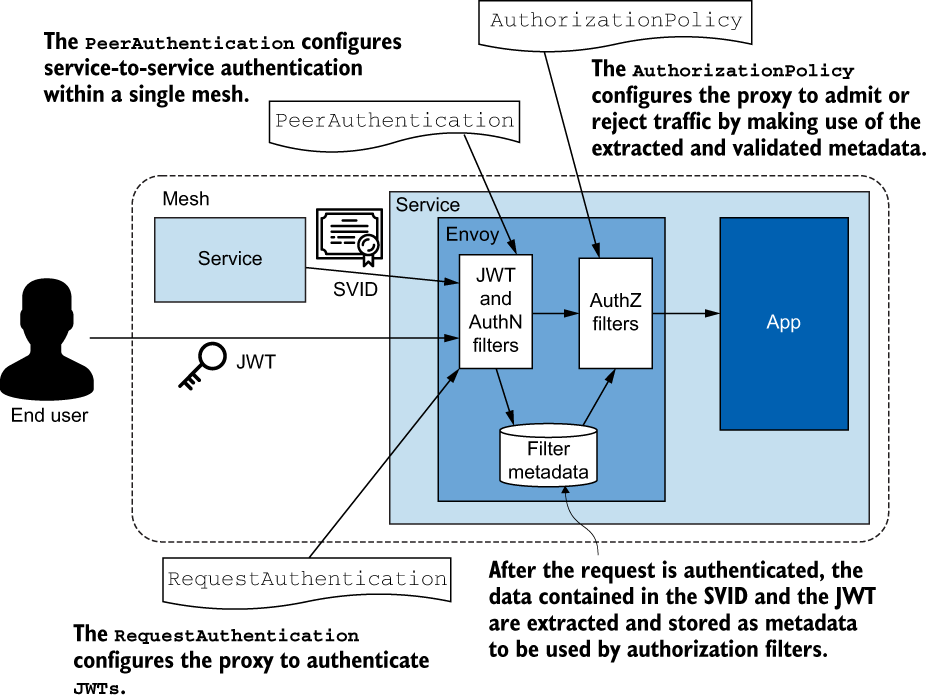

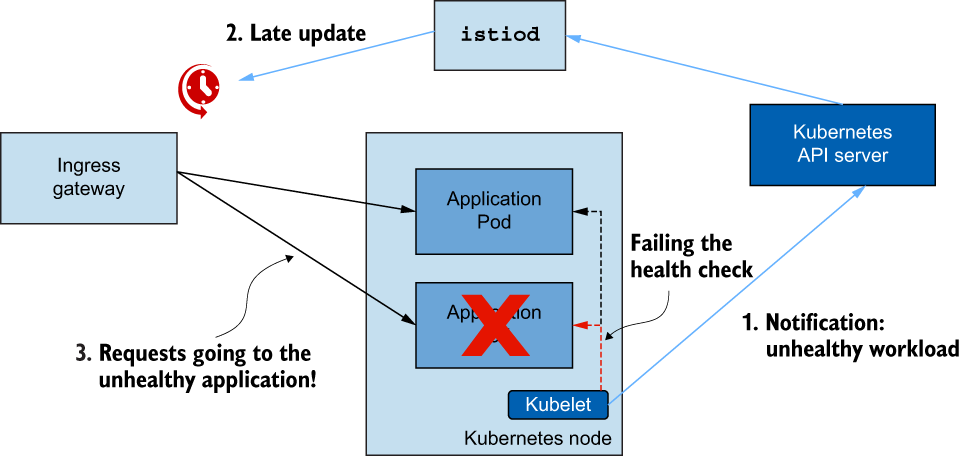

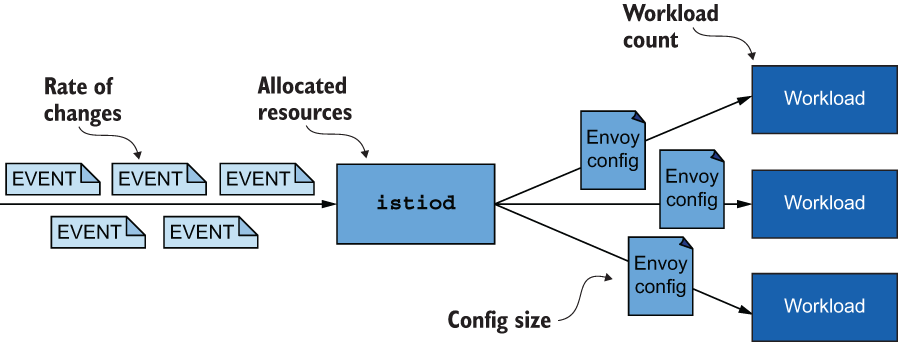

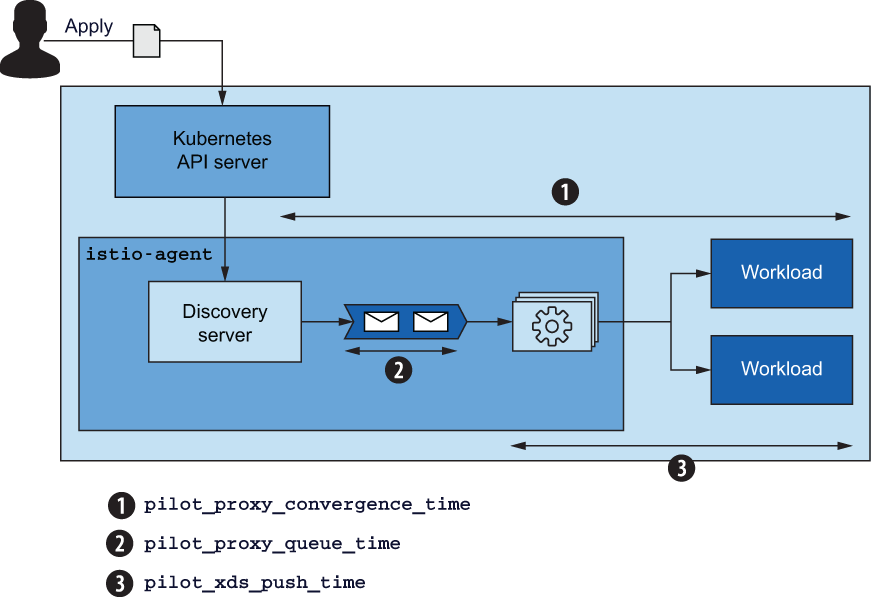

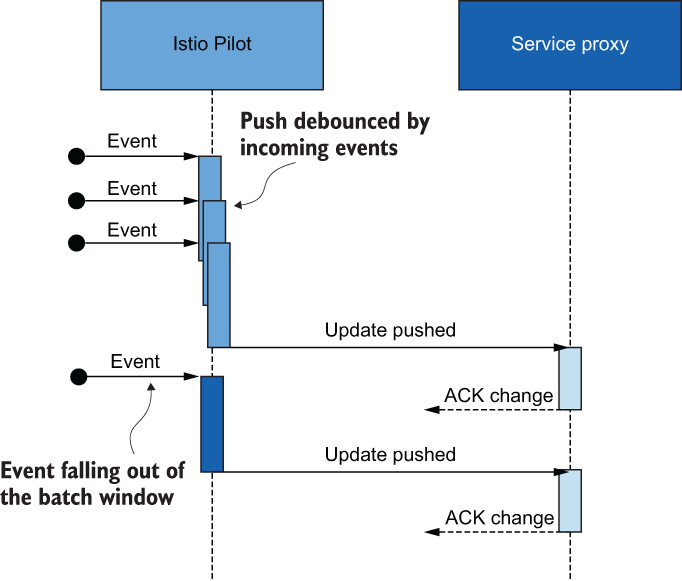

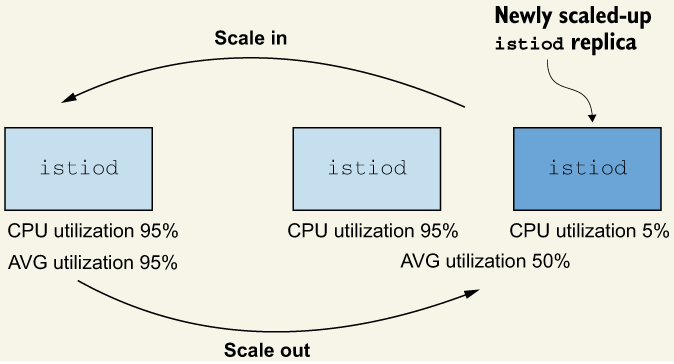

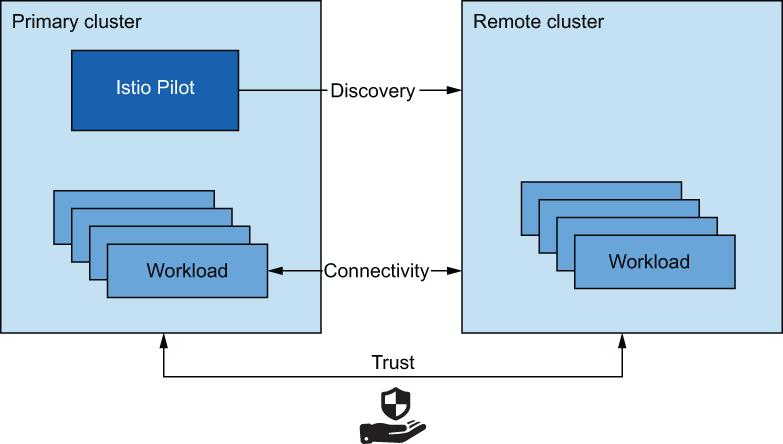

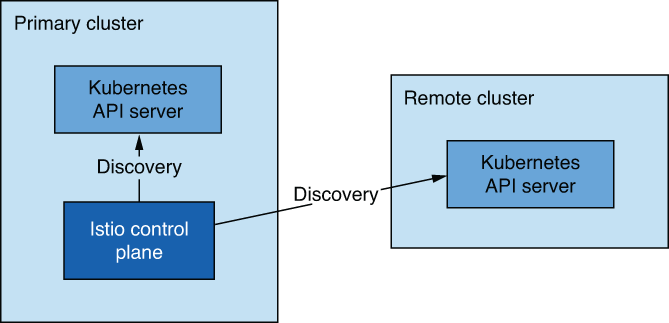

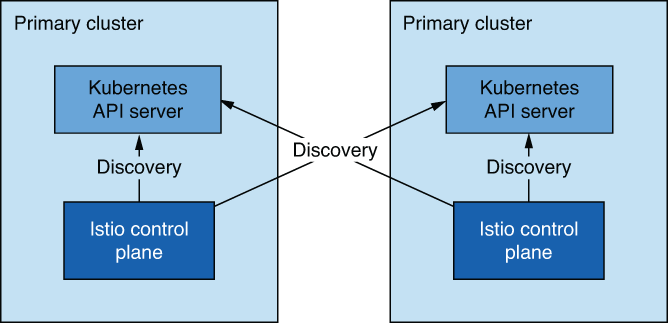

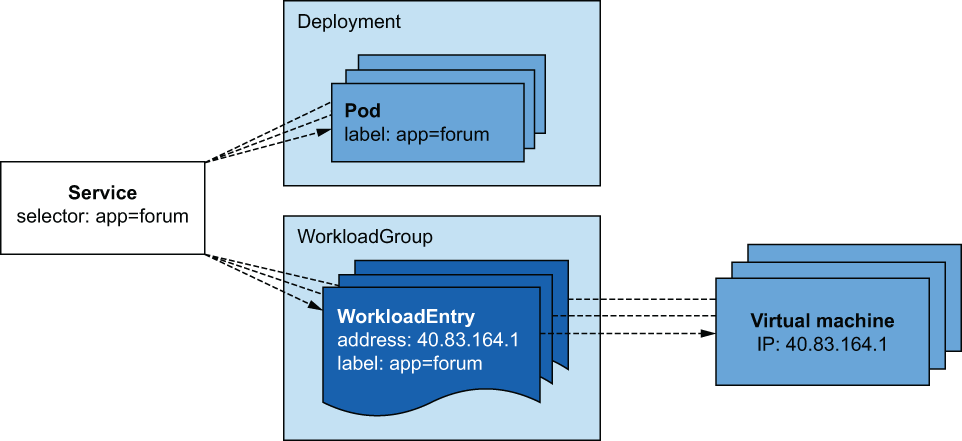

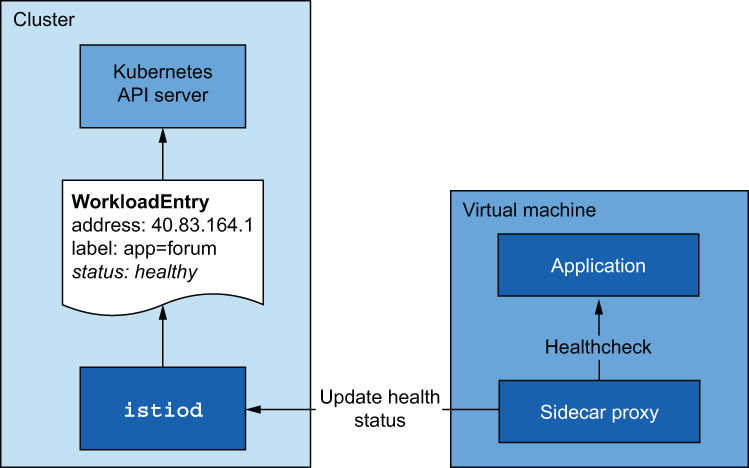

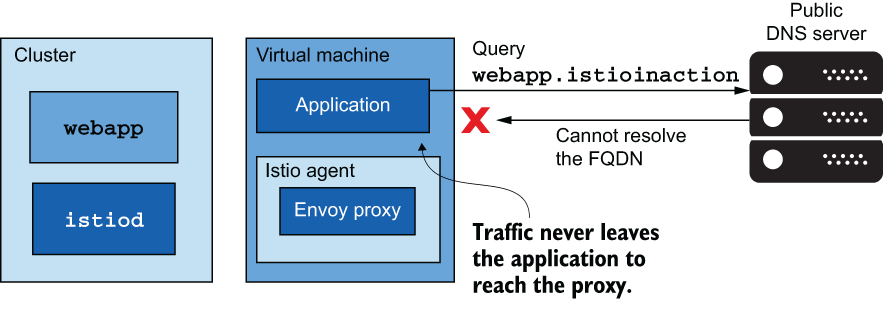

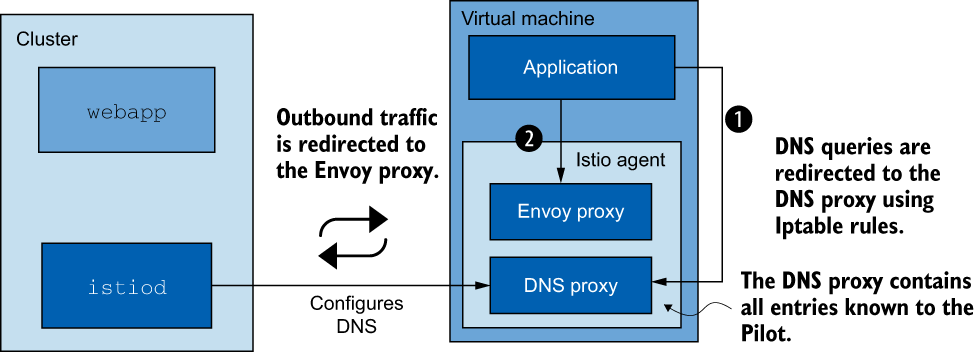

"traceId128bit": true,